机构名称:

¥ 4.0

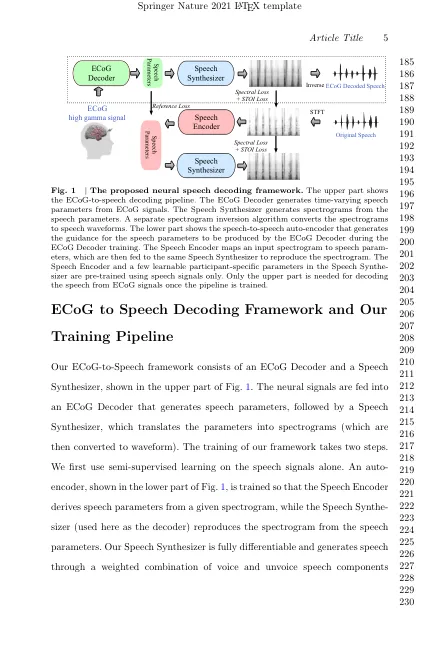

解码器将皮质图(ECOG)信号从皮质转换为可解释的语音参数和一种新型的可区分语音合成器,将语音参数映射到频谱图。我们开发了一个由语音编码器和相同的语音合成器组成的伴侣音频到Audio自动编码器,以生成参考语音参数,以促进ECOG解码器培训。该框架具有自然听起来的语音,并且在48名参与者的队列中高度可重现。在ECOG解码器的三个神经网络架构中,3D Resnet模型在预测原始语音频谱图(PCC = 0.796)的情况下预测原始语音频谱图时具有最佳的解码性能(PCC = 0.804)。我们的实验结果表明,即使仅限于因果操作,我们的模型也可以以高相关性来解码语音,这对于通过实时神经假体采用是必不可少的。我们成功地解码了左或右半球覆盖范围的参与者中的语音,这可能导致左半球损害导致语音缺陷的患者的言语假体。此外,我们使用遮挡分析来识别有助于跨模型语音解码的皮质区域。最后,我们为我们的两阶段培训管道提供开源代码以及协会的预处理和可视化工具,以实现可重现的研究并推动跨语音科学和假体社区的研究。

CBF表达1(ICE1)的诱导剂促进冷 -

主要关键词