机构名称:

¥ 1.0

项目详情:深度学习的快速发展催化了大规模模型的发展,尤其是基于 Transformer 的架构(例如 BERT 和 GPT),它们在自然语言处理、计算机视觉和语音识别领域树立了新的性能标准。尽管这些模型功能强大,但它们需要大量的计算能力和内存,这给资源受限环境下的微调和推理带来了巨大挑战。这种限制阻碍了此类模型在计算资源有限的实际应用中的广泛应用,例如移动设备、边缘计算以及技术基础设施较差的发展中地区。问题陈述:问题的关键在于调整和部署大规模模型需要大量的资源。针对特定任务对这些模型进行微调需要大量的计算工作,通常需要重新训练数百万甚至数十亿个参数。此外,使用这些模型进行推理需要大量的内存和处理能力,这使得实时或设备端应用变得不切实际。我们迫切需要一种能够减少计算和内存开销且不严重影响模型性能的技术。

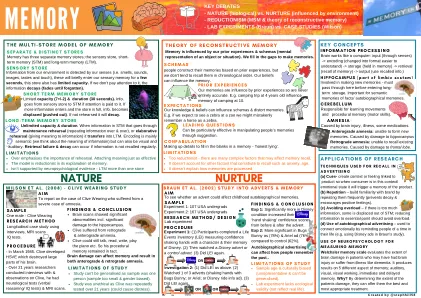

开发高效记忆推理

主要关键词