机构名称:

¥ 1.0

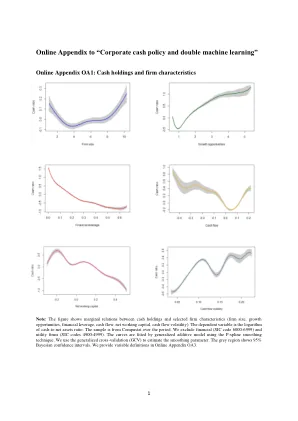

分布式机器学习(ML)在当今的AI服务扩散中发挥了关键作用。分布式ML的典型模型是通过多个工人节点对训练数据集进行分区训练数据集,以并行更新模型参数,采用参数服务器档案。ML培训作业通常是资源弹性,使用具有不同资源配置的各种时间长度完成。分布式ML集群中的一个基本问题是如何探索ML作业的需求弹性并以不同的资源配置安排它们,以便最大化资源的利用并最小化了平均职位完成时间。为了解决它,我们提出了一种在线调度算法,以确定执行时间窗口,到达时的同时工人和参数服务器的数字和类型,目的是最大程度地减少加权平均完成时间。我们的在线算法由(i)在线调度框架组成,该框架将未加工的ML培训作业分组为批次迭代,以及(ii)批处理调度算法,该算法配置每个ML作业以最大程度地提高当前迭代中计划的总重量。我们的在线算法可以保证具有多项式时间复杂性的良好参数化竞争比率。使用现实世界数据进行的广泛评估表明,它在当今的AI云系统中优于最先进的调度程序。

在线安排异质分布式机器学习工作

主要关键词