机构名称:

¥ 1.0

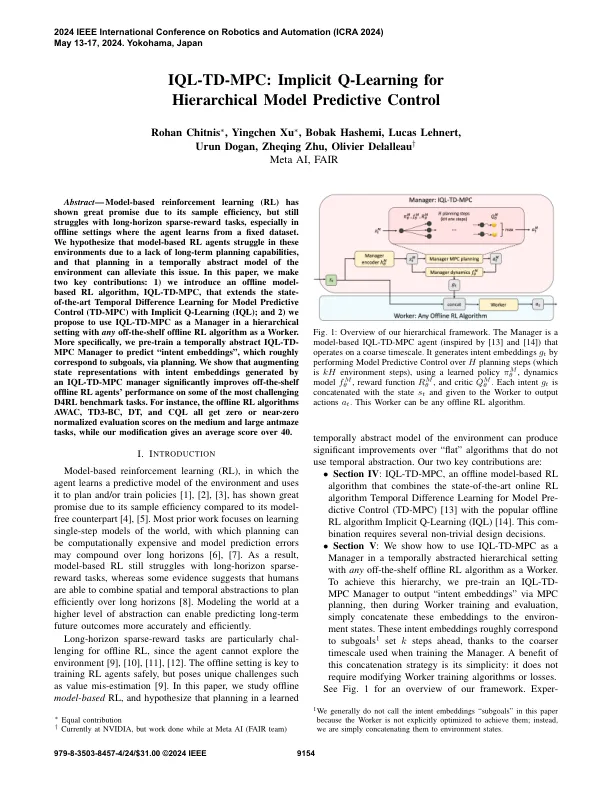

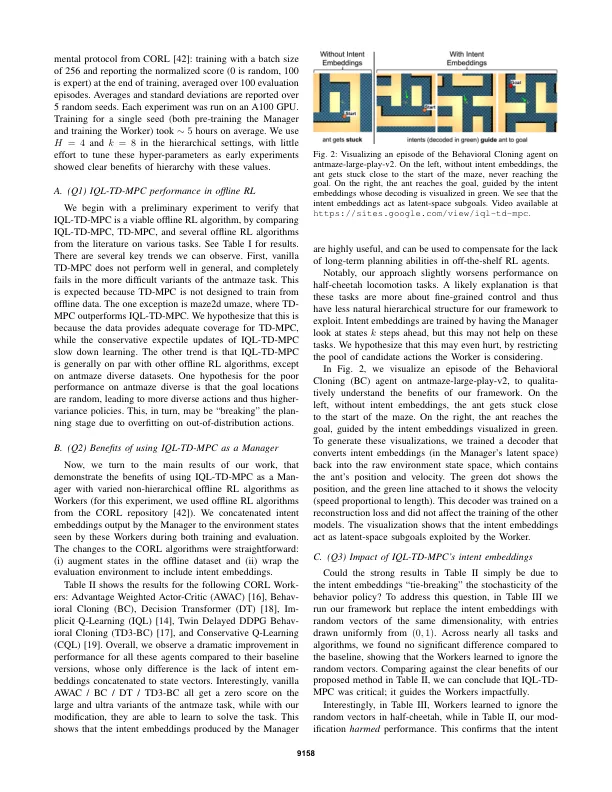

摘要 - 基于模型的增强学习(RL)由于其样本效率而表现出了巨大的希望,但仍在与长马稀疏的任务中挣扎,尤其是在代理商从固定数据集中学习的离线设置中。我们假设由于缺乏长期计划功能,基于模型的RL代理在这些环境中挣扎,并且在环境的时间抽象模型中进行的计划可以减轻此问题。在本文中,我们做出了两个关键的贡献:1)我们引入了基于离线模型的RL算法IQL-TD-MPC,该算法扩展了模型预测性控制(TD-MPC)的状态时间差异学习(TD-MPC),并使用隐式Q-Gearning(IQL); 2)我们建议将IQL-TD-MPC用作层次设置的经理,并以任何离线离线RL算法作为工人。更具体地说,我们预先训练了一种时间抽象的IQL-TD-MPC管理器,以预测“意图嵌入”,该嵌入方式大致与子目标通过计划。我们表明,通过IQL-TD-MPC经理产生的意图嵌入的增强状态表示,可以显着改善离线脱机RL代理在某些最具挑战性的D4RL基准测试任务上的性能。例如,脱机RL算法AWAC,TD3-BC,DT和CQL均在中和大型抗蚁列任务上获得零或接近零的归一化评估得分,而我们的修改给出了40的平均得分。

IQL-TD-MPC:分层模型预测控制

主要关键词