机构名称:

¥ 1.0

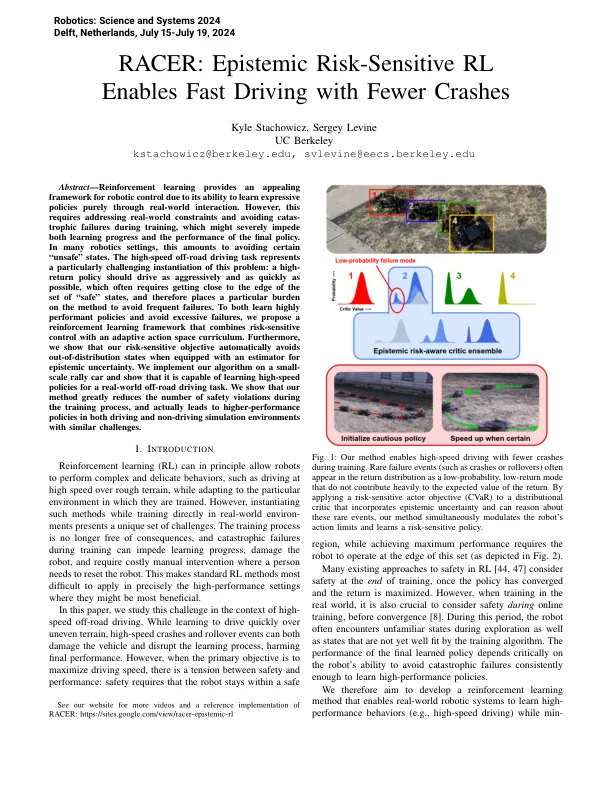

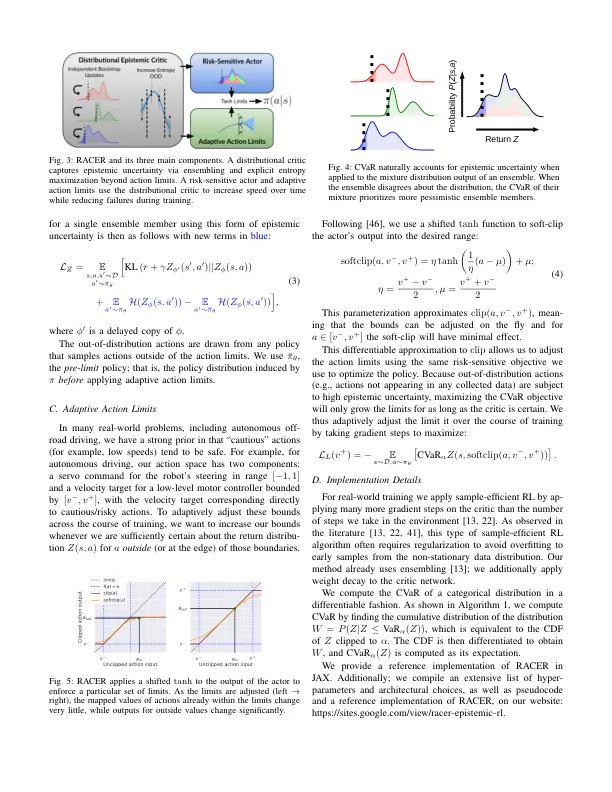

摘要 - 强化学习为机器人控制提供了一个吸引人的框架,因为它仅通过现实世界的互动才能纯粹学习表达政策。但是,这需要解决现实世界的约束并避免在训练过程中造成灾难性失败,这可能会严重阻碍学习进步和最终政策的表现。在许多机器人设置中,这相当于避免某些“不安全”状态。高速越野驾驶任务代表了对此问题的特别挑战性的实例化:高回报策略应尽可能积极地驱动驱动力,通常需要接近“安全”状态集的边缘,因此在该方法上承担特定的负担,以避免频繁失败。既学习高表现的政策,又避免过度失败,我们提出了一个增强学习框架,将对风险敏感的控制与自适应动作空间课程相结合。此外,我们表明我们的风险敏感目标会自动避免配备认知不确定性的估计量。我们在小规模的拉力赛上实施了算法,并表明它能够为现实世界中的越野驾驶任务学习高速政策。我们表明,我们的方法大大减少了培训过程中的安全违规数量,实际上导致在驾驶和非驾驶模拟环境中都具有类似挑战的驾驶和非驾驶模拟环境中的绩效策略。

赛车手:认识论风险敏感的RL可以通过更少的撞车事故进行快速驾驶