机构名称:

¥ 1.0

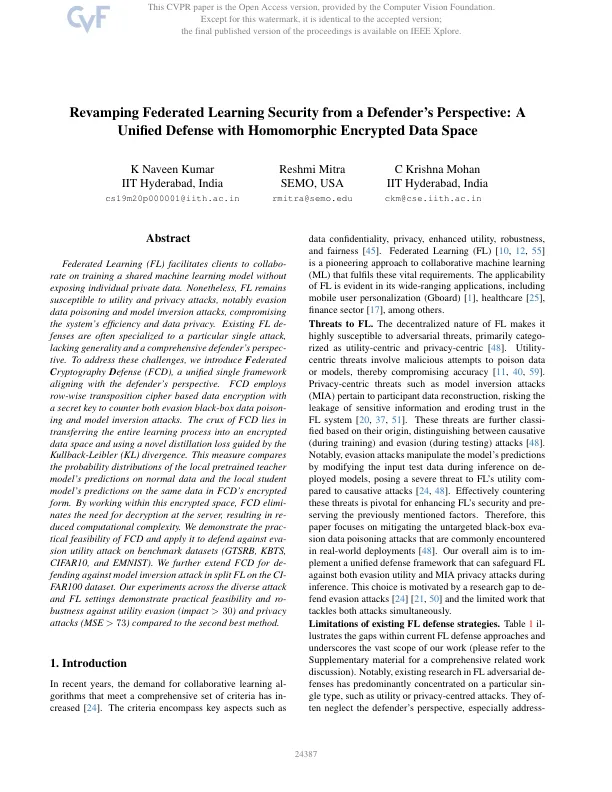

联合学习(FL)促进了客户在培训共享的机器学习模型的情况下合作,而无需公开各个私人数据。尽管如此,FL仍然容易受到效用和隐私攻击的影响,特别是逃避数据中毒和建模反演攻击,从而损害了系统的效率和数据隐私。现有的范围通常专门针对特定的单一攻击,缺乏普遍性和全面的防守者的观点。为了应对这些挑战,我们介绍了f ederpography d efense(FCD),这是一个统一的单框架,与辩护人的观点保持一致。FCD采用基于行的转座密码加密,并使用秘密钥匙来对抗逃避黑框数据中毒和模型反转攻击。FCD的症结在于将整个学习过程转移到加密的数据空间中,并使用由Kullback-Leibler(KL)差异引导的新型蒸馏损失。此措施比较了本地预审最终的教师模型对正常数据的预测以及本地学生模型对FCD加密形式相同数据的预测的概率分布。通过在此加密空间中工作,FCD消除了服务器上的解密需求,从而导致了计算复杂性。我们证明了FCD的实践可行性,并将其应用于对基准数据集(GTSRB,KBTS,CIFAR10和EMNIST)上的Evasion实用程序攻击。我们进一步扩展了FCD,以抵御CI-FAR100数据集中的Split FL中的模型反转攻击。与第二最佳方法相比,我们在各种攻击和FL设置中进行的实验表明了对效用逃避(影响> 30)和隐私攻击(MSE> 73)的实际可行性和巨大性。

具有同态加密数据空间的统一防御

主要关键词