机构名称:

¥ 1.0

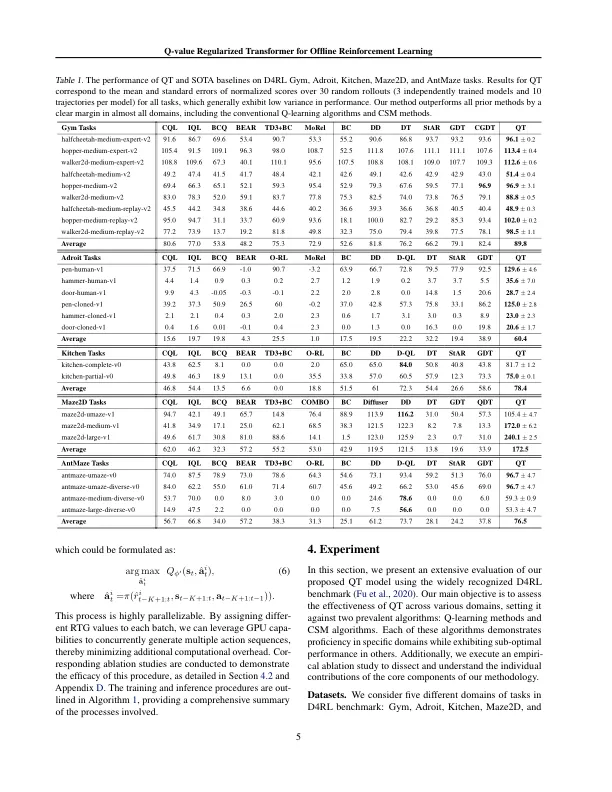

离线增强学习(RL)的最新进步强调了条件序列建模(CSM)的功能,该范例是一种基于历史轨迹和目标返回的范式,该范式学习了动作分布。然而,由于单个轨迹内的采样回报之间的不一致和在多个轨迹之间的最佳回报之间的不一致,这些方法通常与将最佳轨迹缝合在一起的最佳轨迹拼接在一起。幸运的是,动态编程方法(DP)方法通过利用价值函数来近似每个状态的最佳未来回报,提供解决方案,而这些技术容易出现不稳定的学习行为,尤其是在长期和稀疏回报的情况下。在这些见解的基础上,我们提出了Q值重新授权的变压器(QT),该变压器(QT)结合了变压器的轨迹建模能力与DP方法的最佳未来回报的可预测性。QT学习一个动作值函数,并将最大化行动值的术语整合到CSM的培训损失中,该损失旨在寻求与行为政策紧密相符的最佳动作。对D4RL基准数据集的经验评估证明了QT优于传统的DP和CSM方法,这突出了QT在离线RL中增强最新艺术的潜力。

Q值正规变压器用于离线加固学习

主要关键词