机构名称:

¥ 1.0

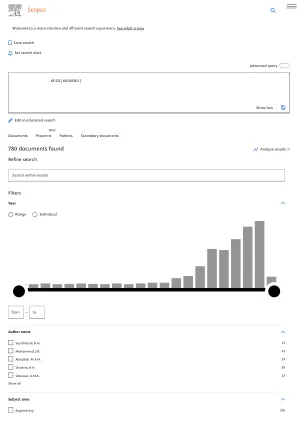

使用*搜索有效地解决大型动作空间的问题对人工智能界一直很重要。这是因为A*搜索的计算和内存要求与动作空间的大小线性增长。当*搜索使用通过计算昂贵的函数近似器(例如深神经网络)学习的启发式功能时,这种负担就变得更加卑鄙。为了解决这个问题,我们介绍了Q*搜索,一种搜索算法,该算法使用深Q-networks指导搜索,以利用一个事实,即可以通过一个深层的Q-Network在不明确产生这些孩子的情况下通过深层Q-Network来计算过渡成本的总和和节点子女的启发式值。这大大减少了计算时间,并且仅需要一个迭代生成一个节点。我们在不同的域和操作空间上使用Q*搜索,表明随着动作尺寸的增加,Q*仅从小型运行时间开销。此外,我们的经验结果表明,Q*搜索的速度最高129倍,并且比*搜索的节点最多生成1288倍。最后,尽管从深处神经网络中获得可允许的启发式函数是一个持续的研究领域,但我们证明Q*搜索被保证在启发式功能的情况下找到最短的路径并不能过分估计该州的过渡成本和成本的总和。

Q*搜索:启发式搜索with Q-networks

主要关键词