机构名称:

¥ 1.0

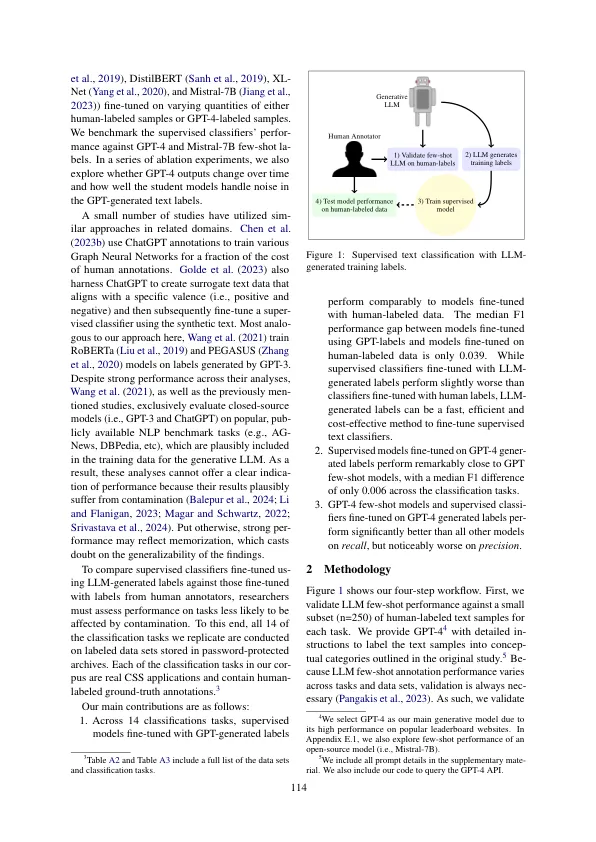

计算社会科学(CSS)的实践通常依靠人标记的数据来调查监督的文本分类器。我们评估了研究人员使用来自生成大语言模型(LLM)的替代培训标签增强或替换人类生成的培训数据的潜力。我们介绍了推荐的工作流程,并通过复制14个分类任务和测量性能来测试此LLM应用程序。我们采用了来自高影响力期间CSS文章的新型英语文本分类数据集。由于这些数据集存储在受密码保护的档案中,因此我们的分析不太容易受到污染问题。对于每项任务,我们将使用GPT-4标签的监督分类器进行了比较,并用人类注释进行了微调的分类器,并与GPT-4和Mismtral-7b的标签进行了微调,并以较少的镜头在上下文中学习。我们的发现表明,在LLM生成的标签上微调的监督分类模型与通过人类注释者的标签进行了微调的模型相当。使用LLM生成标签的微调模型可以是构建监督文本分类器的快速,高效且具有成本效益的方法。

自动注释中的知识蒸馏:具有LLM生成培训标签的监督文本分类

主要关键词