机构名称:

¥ 1.0

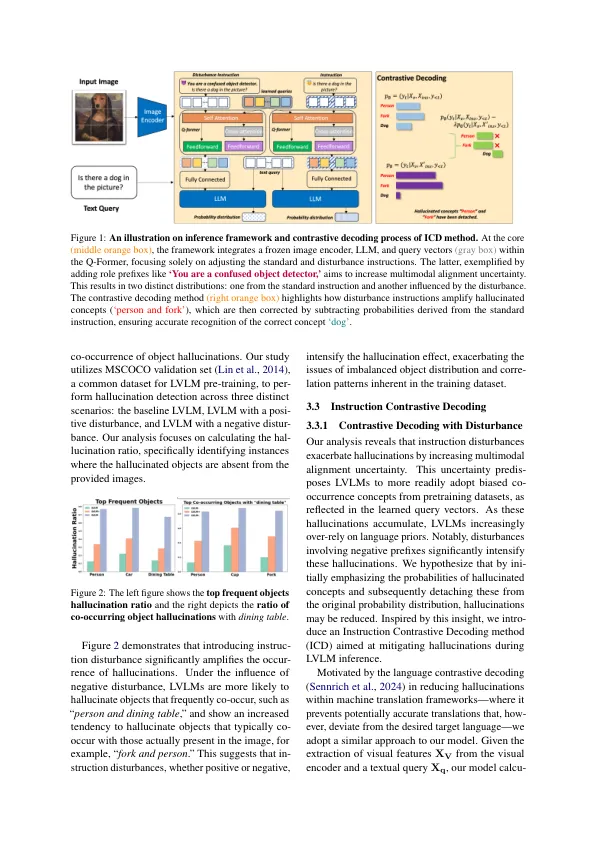

大型视觉模型(LVLM)越来越擅长从视觉输入中产生上下文详细且相干的响应。然而,它们在多模态决策和开放式的一代中的应用受到了明显的Hal-Lucinations的限制,因为生成的文本不准确地代表了视觉内容。为了解决这个问题,本文介绍了指令解码(ICD)方法,这是一种旨在减少LVLM推论的幻觉的新颖性。我们的方法的灵感来自我们的观察,即我们所说的干扰指令在多模层融合模块中显着加剧了幻觉。ICD会从标准和指导扰动中进行分布,从而增加对齐不确定性,并有效地从原始分布中减去幻觉的概念。通过对犯罪基准(POPE和MME)和生成基准(Llava-Bench)的全面实验,我们证明ICD显着减轻了对象级别和属性级别的幻觉。此外,我们的方法不仅解决了幻觉,而且还显着增强了LVLMS的一般感知和识别。

通过教学对比解码