机构名称:

¥ 2.0

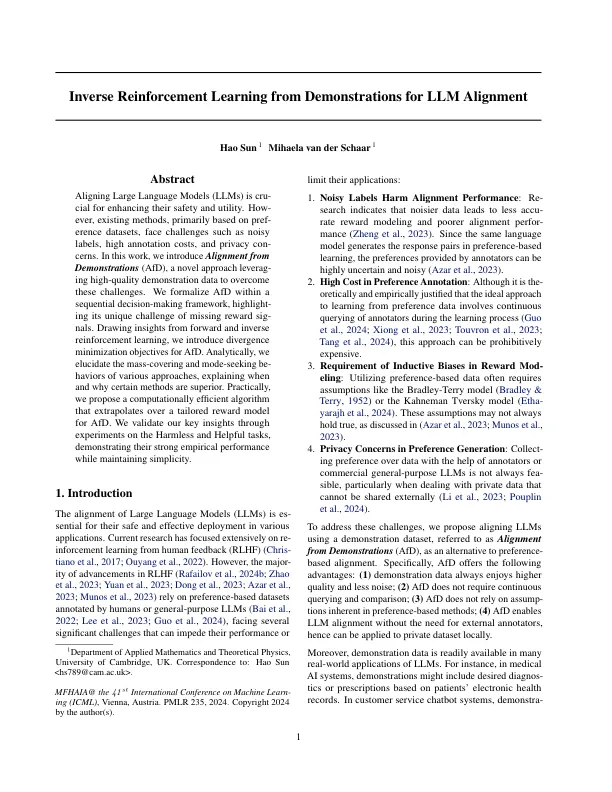

对齐大语言模型(LLMS)正在提高其安全性和实用性。,现有方法主要基于偏爱的数据集,面临噪音标签,高注释成本和隐私性征服等挑战。在这项工作中,我们引入了示范(AFD)的一致性,这是一种新型的方法,掌握了高质量的演示数据以克服这些挑战。我们在一个顺序的决策框架内将AFD形式化,这强调了其缺失奖励的独特挑战。从前进和逆增强学习中汲取见解,我们引入了AFD的分歧最小化目标。在分析上,我们阐明了各种方法的质量覆盖和寻求模式,并解释了某些方法何时以及为什么较高的方法。实际上,我们提出了一种计算有效的算法,该算法通过针对AFD的量身定制奖励模型进行推断。我们通过实验无害和有用的任务来验证我们的关键见解,在保持简单性的同时证明了它们的强大经验表现。

从LLM对齐的示范中学习的逆增强学习

主要关键词