机构名称:

¥ 2.0

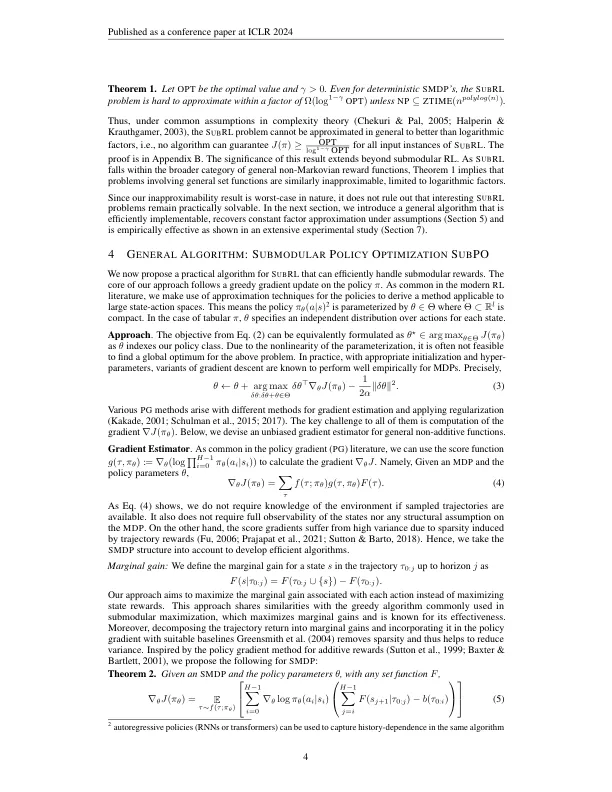

在加强学习(RL)中,国家的奖励通常被认为是增加的,并且按照马尔可夫的假设,它们独立于先前访问的状态。在许多重要的应用中,例如覆盖范围控制,实验设计和信息性路径计划,奖励自然会降低回报,即鉴于以前访问过的类似状态,其价值会降低。为了解决这个问题,我们提出了subsodular rl(s ub rl),该范式旨在优化通过捕获降低回报的subsodular Set函数模拟的更通用的,非添加的(和历史依赖的)奖励。不幸的是,即使在表格设置中,我们也表明,所产生的优化问题很难近似。是出于贪婪算法在经典次次优化方面的成功的动机,我们提出了S ub po,这是一种基于政策梯度的简单梯度al-gorithm,用于S ub rl,通过贪婪地最大化边际增长来处理非增长的重新奖励。的确,在基础马尔可夫决策过程(MDP)的一些假设下,s ub po恢复了子模块的最佳常数因子近似值。此外,我们得出了一种自然政策梯度方法,即使在大型州和行动空间中,也可以在本地优化S UB RL实例。我们通过将S UB PO应用于生物多样性监测,贝叶斯实验设计,信息路径计划和覆盖范围最大化等多种应用来展示我们的方法的多功能性。我们的结果证明了样本效率以及对高维状态行动空间的可伸缩性。

suppodular增强学习

主要关键词