机构名称:

¥ 1.0

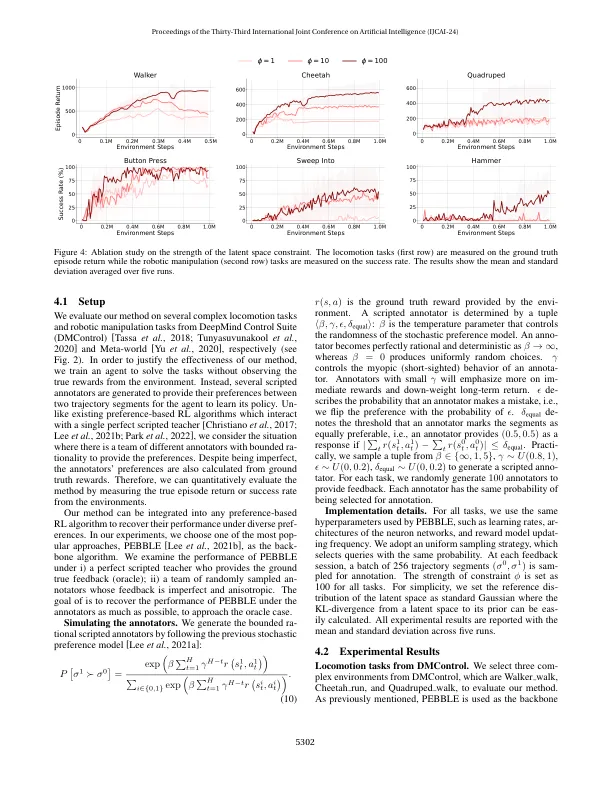

设计奖励功能的复杂性一直是深入强化学习(RL)技术的广泛应用的主要障碍。描述代理商的所需行为和属性也可能很困难。一种新的范式,称为从人类优先(或基于偏好的RL)学习的强化学习已成为有前途的解决方案,其中从BE-HAVIOR轨迹之间从人类偏好标签中学到了奖励功能。但是,现有的基于首选项的RL的方法受到准确的Oracle首选项标签的限制。本文通过开发一种从各种人类偏好中学习的方法来限制这种局限性。关键思想是通过在潜在空间中的规范和纠正来稳定奖励学习。为了确保时间一致性,对奖励模型施加了强大的限制,该模型迫使其范围的空间接近非参数分配。此外,基于置信的奖励模型结合方法旨在产生更稳定和可靠的预测。对DMCON-trol和Meta-World中的各种任务进行了测试,并在从不同的反馈中学习时,对现有基于首选项的RL算法显示出一致且显着的改进,为RL方法的现实世界应用铺平了道路。

增强人类偏好的学习

主要关键词