机构名称:

¥ 2.0

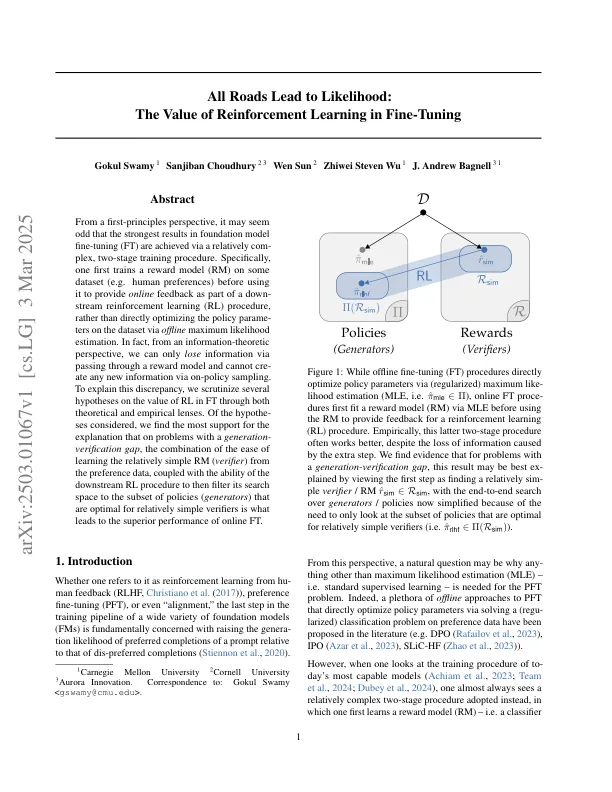

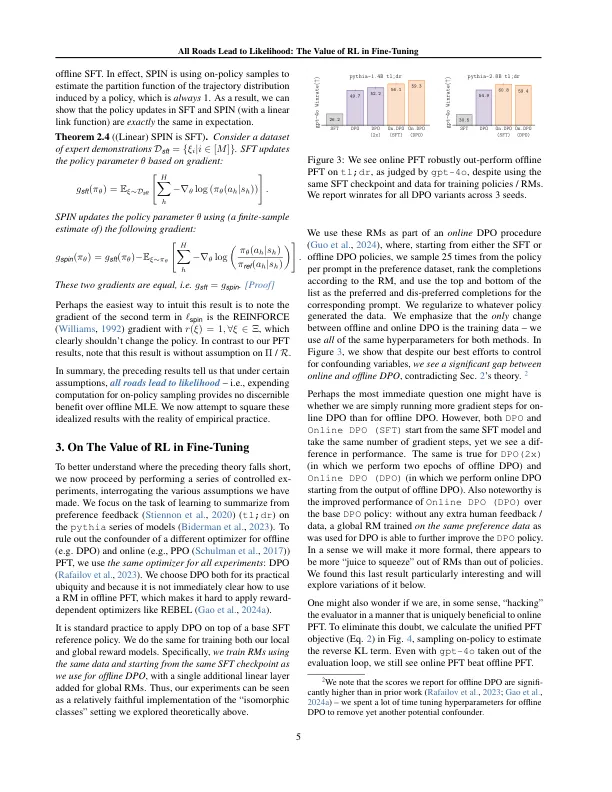

从第一原理的角度来看,基础模型微调(FT)的最强结果是通过相对较高的两阶段训练程序实现的。具体来说,第一次训练某些数据集上的奖励模型(RM)(例如,人类的偏好)在使用它作为向下流增强学习(RL)过程的一部分提供在线反馈之前,而不是通过离线最大可能性估计来直接优化数据集中的策略参数。实际上,从信息理论的角度来看,我们只能通过通过奖励模型来丢失信息,并且不能通过policy采样来培养任何新信息。为了解释这种差异,我们通过理论和经验镜头对RL的价值进行了几个假设。考虑到假设的考虑,我们找到了对解释的最大支持,即在具有一代验证差距的问题上,从偏好数据中学习相对简单的RM(验证者)的易用性结合在一起,再加上下游RL程序的能力,以便在线搜索范围(最佳)的范围(生成器)的范围(生成器)的范围(生成器)的范围(生成器)的范围是最佳的。英尺

微调中的增强学习价值

主要关键词