机构名称:

¥ 2.0

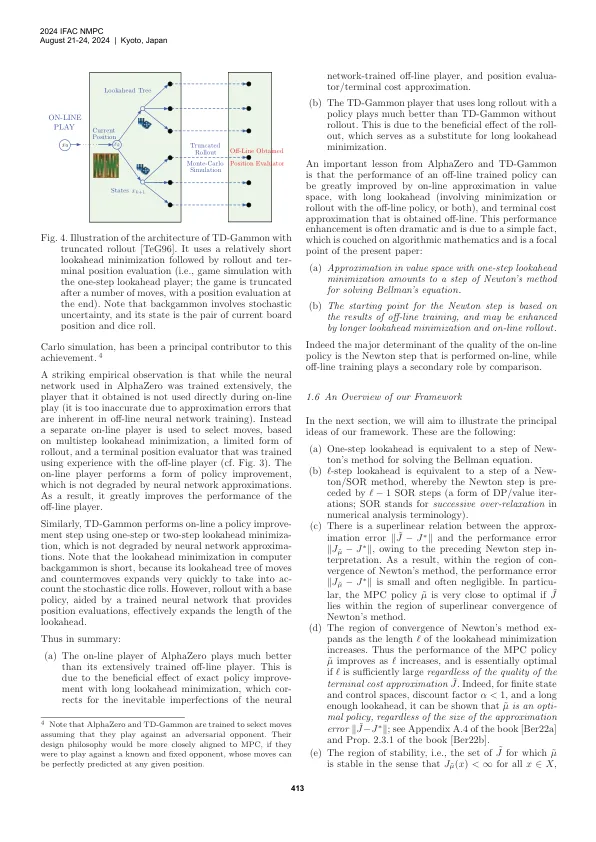

摘要:在本文中,我们描述了一个新的概念框架,该概念框架连接近似动态编程(DP),模型预测控制(MPC)和加固学习(RL)。该框架以两种算法为中心,这些算法在很大程度上是彼此独立的,并通过牛顿方法的强大机制在协同作用中起作用。我们称它们为“线”训练和在线播放算法。名称是从涉及游戏的RL的一些主要成功中借来的;主要示例是最近(2017年)Alphazero程序(下棋,[SHS17],[SSS17])和类似结构化的和早期(1990年代)TD-Gammon程序(扮演Backgammon,[Tes94],[TES95],[TES95],[TEG96,[TEG96]))。在这些游戏上下文中,O效率训练算法是一种教授该程序如何评估位置并在任何给定位置产生良好动作的方法,而在线游戏算法是一种实时对抗人或计算机对手的方法。显着,在线训练和在线比赛之间的协同作用也构成了MPC的基础(以及其他主要的顺序决策问题类别),实际上MPC设计体系结构与Alphazero和TD-Gammon的一种非常相似。这种概念上的见解提供了弥合RL和MPC之间文化差距的工具,并为MPC中的某些基本问题提供了新的启示。这些包括通过推出来增强稳定性,通过使用确定性等效性来处理不确定性,MPC在涉及更改系统参数的自适应控制设置中的弹性以及由牛顿方法所暗示的超线性绩效界限提供的见解。

模型预测控制和增强学习

主要关键词