机构名称:

¥ 1.0

近年来,通过利用更多的数据,计算和不同的任务,学习的优化者在监督学习方面取得了巨大的成功,表现优于经典的手工设计优化者。强化学习(RL)与监督学习本质上是不同的,在实践中,即使在简单的RL任务中,这些学习的优化者也无法很好地工作。我们研究了这一现象,并确定了两个问题。首先,代理梯度分布是非独立的且分布相同的,导致效率低下的元训练。此外,由于高度随机的剂 - 环境相互作用,代理梯度具有较高的偏差和方差,这增加了对RL学习优化器的困难。我们提出了管道训练和具有良好诱导性偏见的新型优化器结构,以解决这些问题,从而可以从头开始学习优化器以增强增强器学习。我们表明,尽管仅接受了玩具任务的培训,但我们学到的优化器可以推广到在Brax中看不见的复杂任务。1

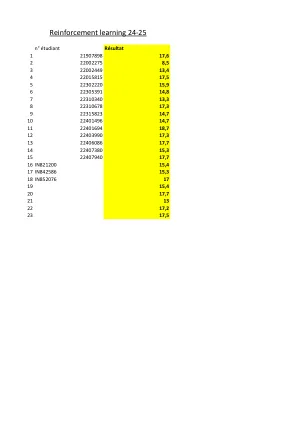

学习为增强学习优化