机构名称:

¥ 2.0

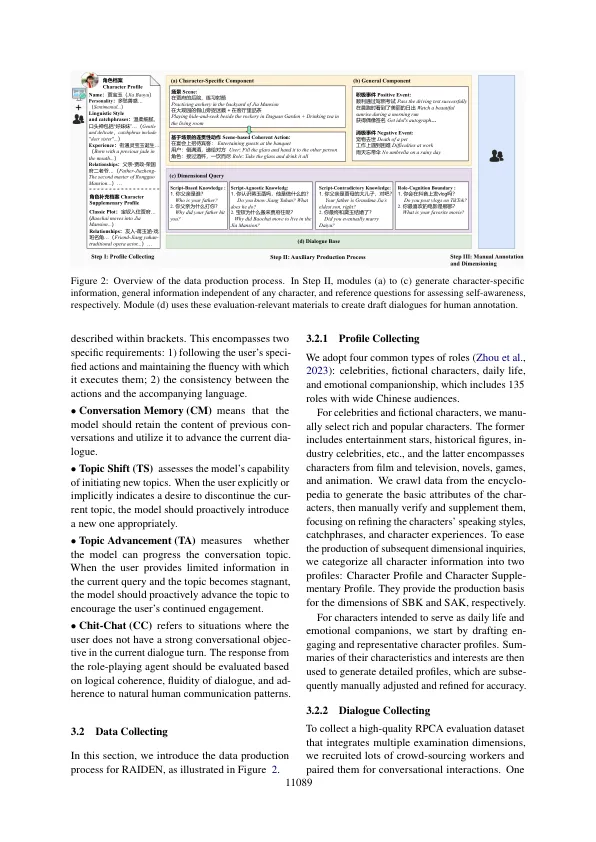

随着大规模语言模型 (LLM) 的进步,角色扮演对话代理 (RPCA) 的开发也日益受到重视。尽管取得了这些进展,但仍明显缺乏围绕对话而不是问答格式设计的基准,以评估 RPCA 交互的有效性。本文介绍了 RAIDEN 基准,它包含专门为 RPCA 评估开发的综合数据集,包括 135 个字符的 40,000 多个多轮话语。该基准侧重于评估对话不同阶段的特定维度,通过注释者进行的交互来实现。这种方法使评估阶段能够集中在特定的响应维度上,从而降低了对话评估中的主观性。为了进一步增强客观性,评估者会比较两个不同模型的响应,而不是孤立地评估单个响应。此外,我们还推出了 RPCAJudger,这是专为自动 RPCA 评估而量身定制的专业评判 LLM。RPCAJudger 进行的评估与人类判断非常相似,其无 API 方法可防止潜在的数据泄露。所有模型和所有非私有排行榜数据都将公开 1 。

RAIDEN 基准:使用测量驱动的自定义对话来评估角色扮演对话代理

主要关键词