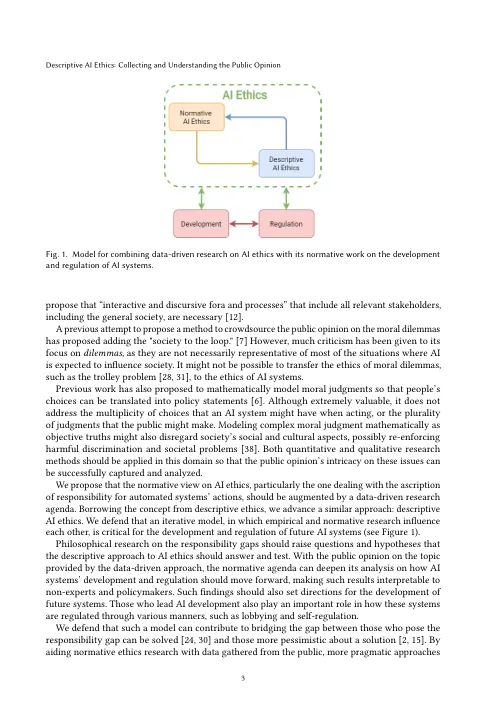

鉴于人工智能 (AI) 系统给社会带来的重大变化,许多学者讨论了它们的影响是否以及如何产生积极和消极影响 [21]。随着我们开始在各种道德和法律突出的环境中遇到人工智能系统,一些人已经开始探索如何调整当前的责任归属实践以适应这些新技术 [19, 33]。当今的一个批判观点是,自主和自学习的人工智能系统带来了所谓的责任缺口 [27]。这些系统的自主性挑战了人类对它们的控制 [13],而它们的适应性导致了不可预测性。因此,如果这些系统造成任何损害,将责任追溯到特定实体可能是不可行的。将责任实践视为对代理人采取某些态度 [40],学术研究也提出了人工智能系统是否是此类实践的适当主体的问题 [15, 29, 37] — — 例如,它们可能“有身体可踢”,但“没有灵魂可诅咒” [4]。责任差距的困境不仅限于道德领域,也延伸到法律实践 [5, 9]。当前的法律机构没有能力处理这些问题 [36]。自学习算法的性质对这些系统设计者与可能造成的损害之间的近因关系提出了挑战 [29]。如果这些系统不能补救受到伤害的人或从错误中吸取教训,那么让它们为自己的行为负责是没有意义的。因此,对人工智能系统的惩罚是一个开放且有争议的问题 [3]。我们重点关注当前解决责任差距的规范性努力的局限性。他们讨论了人工智能系统可以并且应该如何嵌入到我们的责任实践中。现有研究将责任视为一个关系概念,即一个人要让做错事的人对特定的行为或后果负责 [ 13 ],或者代理人要对患者负责 [ 18 ],而忽略了参与此类实践的个人的意见。目前缺乏实证研究来了解普通公众(那些可能遭受人工智能系统损害的人群)如何看待这些差距,以及如何解决这些问题。在自动驾驶汽车领域已经有一些研究 [ 8 , 25 ],但对于人们如何为自动驾驶系统的行为分配责任、责备和惩罚,我们缺乏更广泛的理解;人工智能以多种形式和环境部署,很少有研究 [26, 39] 解决其他道德上突出的情况。近年来,人工智能的伦理问题越来越受到关注 [ 38 ]。算法部署所引发的许多问题已在学术界和工业界引起了广泛的争论。人们曾尝试了解人们如何看待人工智能系统的伦理问题,如偏见/公平性[ 23 , 35 ]和隐私[ 43 ]。然而,公众舆论尚未在更大范围内被捕捉和理解。在以下章节中,我们将捍卫公众舆论在讨论人工智能伦理时是宝贵和不可或缺的,重点关注责任差距,并提出如何

描述性人工智能伦理:收集和理解公众意见

主要关键词