机构名称:

¥ 1.0

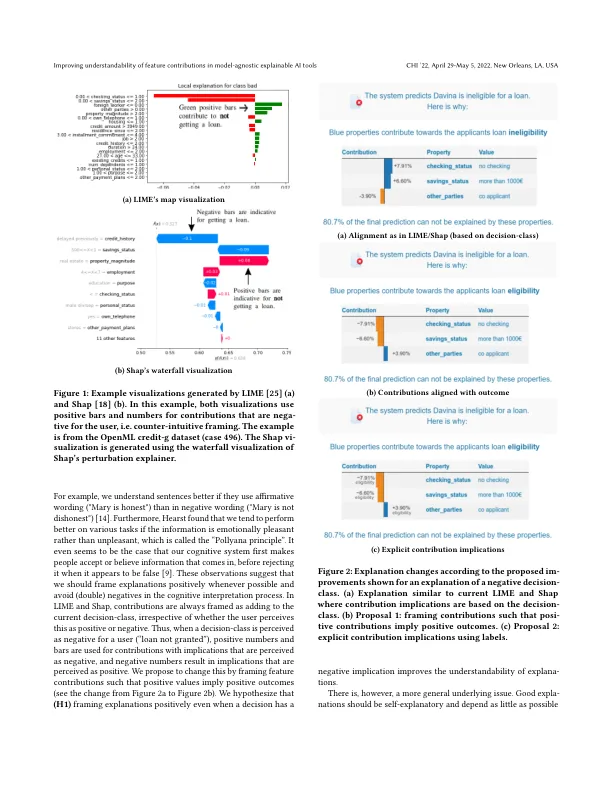

与模型无关的可解释人工智能工具通过“局部”特征贡献来解释其预测。我们通过实证研究了两种优于当前方法的潜在改进。第一种方法是始终以用户认为对结果有积极贡献的形式来呈现特征贡献(“积极框架”)。第二种方法是添加“语义标签”,解释每个特征贡献的方向性(“该特征可使合格率提高 5%”),从而减少额外的认知处理步骤。在一项用户研究中,参与者评估了针对贷款申请和音乐推荐的不同框架和标签条件的解释的可理解性。我们发现,即使预测为负面,积极框架也能提高可理解性。此外,添加语义标签可以消除任何框架对可理解性的影响,积极标签的表现优于消极标签。我们在 ArgueView[11] 包中实现了我们的建议。

不可知可解释的人工智能工具 - TUE 研究门户