机构名称:

¥ 1.0

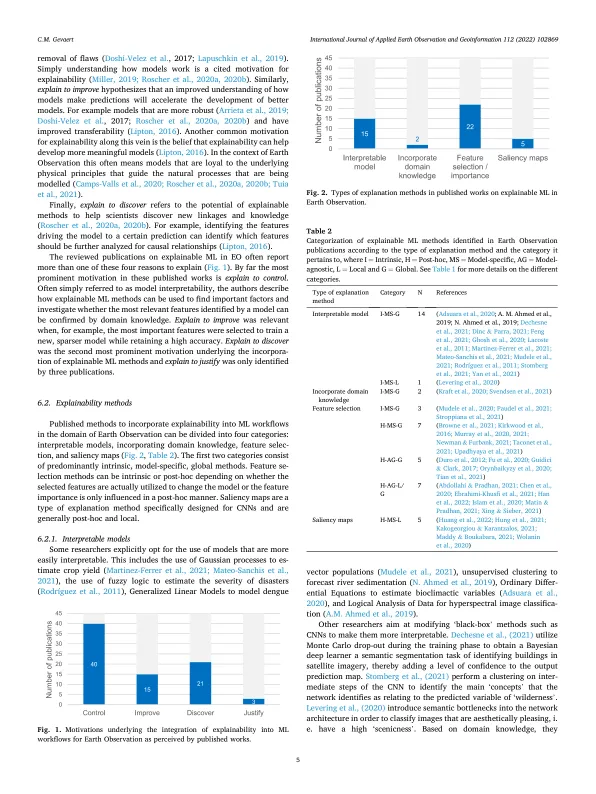

人工智能和机器学习在地球观测 (EO) 和遥感领域无处不在。与它们在计算机视觉领域的成功相一致,它们已被证明可以在 EO 应用中获得高精度。然而,在将复杂的机器学习模型用于特定应用之前,EO 专家还应考虑其弱点。其中一个弱点是复杂的深度学习模型缺乏可解释性。本文回顾了地球观测领域已发表的可解释 ML 或可解释 AI 示例。可解释性方法分为:内在解释与事后解释、模型特定与模型无关、全局解释与局部解释,并提供了每种类型的示例。本文还确定了社会科学和即将出台的联合国教科文组织人工智能伦理监管建议以及欧盟人工智能法案草案中的关键可解释性要求,并分析了这些限制在 EO 领域是否得到充分解决。研究结果表明,对于哪些模型可以被视为可解释或不可解释尚不明确。 EO 应用通常使用随机森林作为“可解释的”基准算法来与复杂的深度学习模型进行比较,尽管社会科学明确指出大型随机森林不能被视为可解释的基准算法。其次,大多数解释针对的是领域专家,而不是算法的潜在用户、监管机构或可能受算法决策影响的人。最后,出版物往往只是提供解释,而没有通过目标受众测试解释的实用性。鉴于这些社会和监管方面的考虑,我们提供了一个框架来指导选择合适的机器学习算法,该框架基于是否有具有高预测精度的更简单的算法以及解释的目的和目标受众。

用于地球观测的可解释人工智能

主要关键词