机构名称:

¥ 1.0

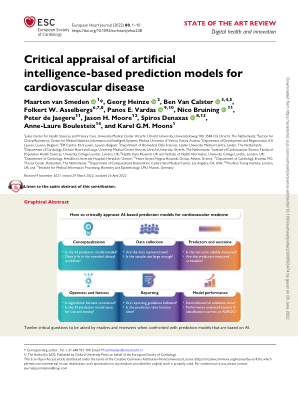

摘要 人工智能的原理是模仿人类智能,通过从各种来源获取的数据进行学习,执行任务、识别模式或预测结果。人工智能和机器学习算法已广泛应用于自动驾驶、电子商务和社交媒体中的推荐系统、金融科技、自然语言理解和问答系统。人工智能也在逐渐改变医疗研究的格局(Yu et al. in Biomed Eng 2:719–731, 25)。半个世纪前,依赖于医学知识的整理和稳健决策规则的构建的基于规则的方法在疾病诊断和临床决策支持中引起了极大关注。近年来,能够解释特征之间复杂相互作用的机器学习算法(如深度学习)在医疗领域的预测模型中显示出良好的前景(Deo in Circulation 132:1920–1930, 26)。尽管许多人工智能和机器学习算法可以实现非常高的性能,但由于其中一些算法缺乏可解释性,因此通常很难在实际临床环境中完全采用。可解释人工智能 (XAI) 正在兴起,以协助向医疗保健专业人员传达内部决策、行为和行动。通过解释预测结果,XAI 赢得了临床医生的信任,因为他们可以学习如何在实际情况中应用预测模型,而不是盲目遵循预测。由于医学知识的复杂性,仍有许多场景需要探索如何使 XAI 在临床环境中有效。

用于医疗保健预测模型的可解释人工智能