机构名称:

¥ 1.0

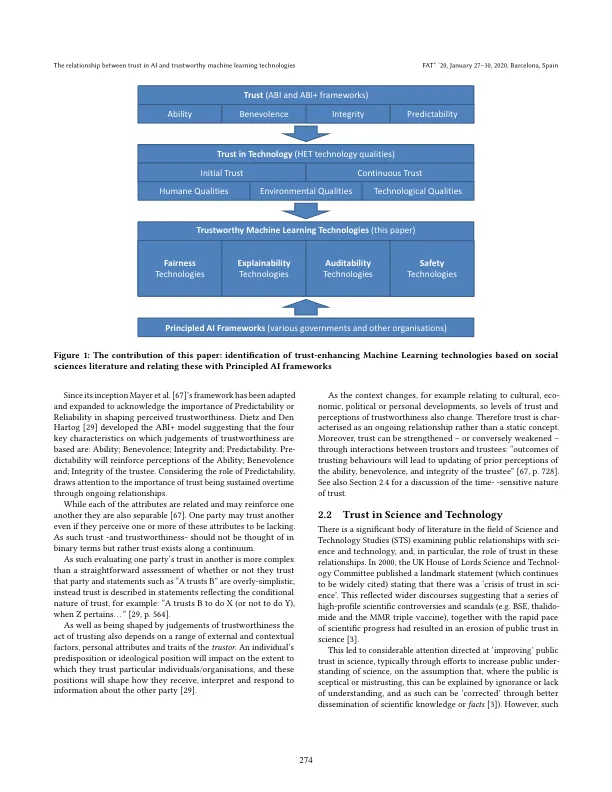

为了设计和开发用户和广大公众可以合理信任的基于人工智能的系统,我们需要了解机器学习技术如何影响信任。为了指导可信的基于人工智能系统的设计和实施,本文提供了一种系统的方法,将社会科学中关于信任的考虑与针对基于人工智能的服务和产品提出的可信技术联系起来。我们从 ABI+(能力、仁慈、正直、可预测性)框架开始,并辅以最近提出的 ABI+ 在支持信任的技术品质上的映射。我们考虑了四类机器学习可信技术,即公平性、可解释性、可审计性和安全性 (FEAS),并讨论这些技术是否以及如何支持所需的品质。此外,信任会在基于人工智能的系统的整个生命周期中受到影响,因此我们引入了信任链的概念来讨论生命周期各个阶段的可信技术。通过这种方式,我们确定了机器学习技术支持可信的基于人工智能的系统的方式。最后,FEAS 与已知框架具有明显的关系,因此我们将 FEAS 与近年来出现的各种国际“原则性 AI”政策和技术框架联系起来。

人工智能信任与值得信赖的机器学习技术之间的关系