机构名称:

¥ 1.0

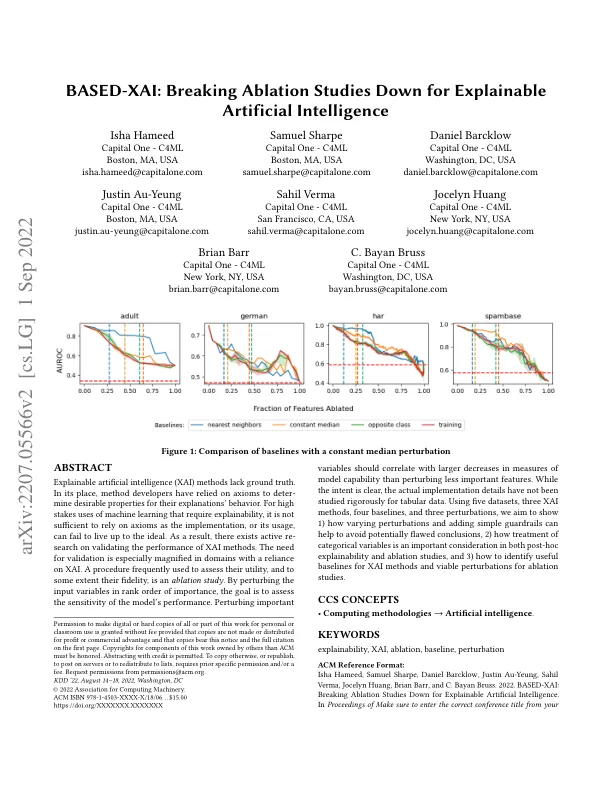

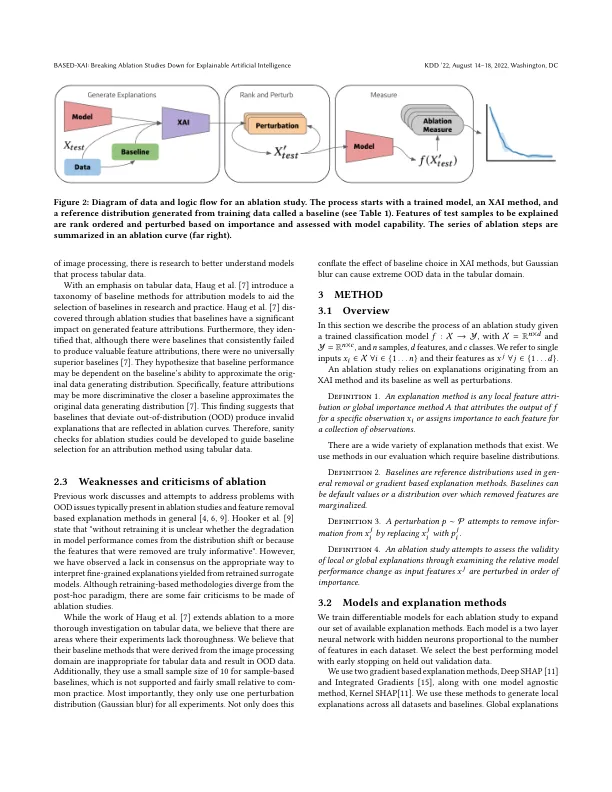

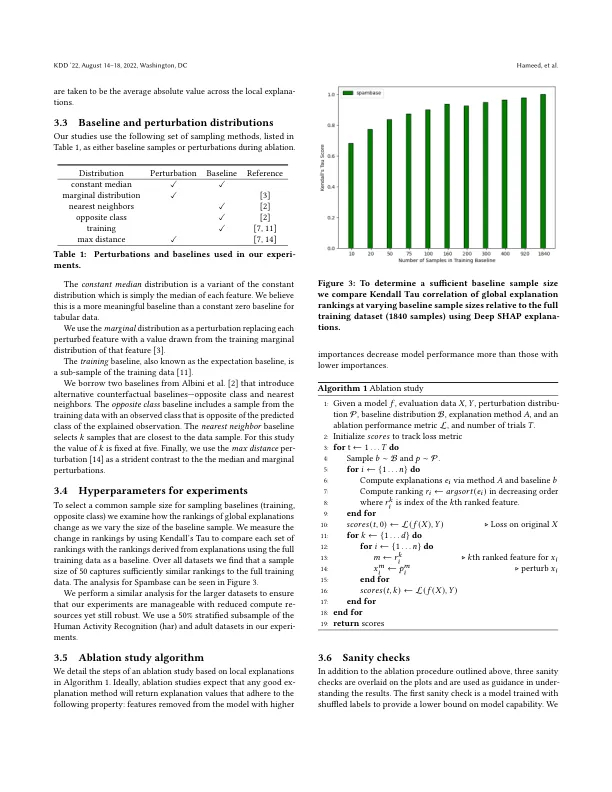

可解释的人工智能 (XAI) 方法缺乏基本事实。取而代之的是,方法开发人员依靠公理来确定其解释行为的理想属性。对于需要可解释性的高风险机器学习用途,仅仅依靠公理是不够的,因为实现或其使用可能无法达到理想状态。因此,目前存在对验证 XAI 方法性能的积极研究。在依赖 XAI 的领域,验证的需求尤其突出。一种经常用于评估其效用(在某种程度上是其保真度)的程序是消融研究。通过按重要性排序扰动输入变量,目标是评估模型性能的敏感性。扰动重要的

BASED-XAI:分解消融研究,实现可解释的人工智能