机构名称:

¥ 1.0

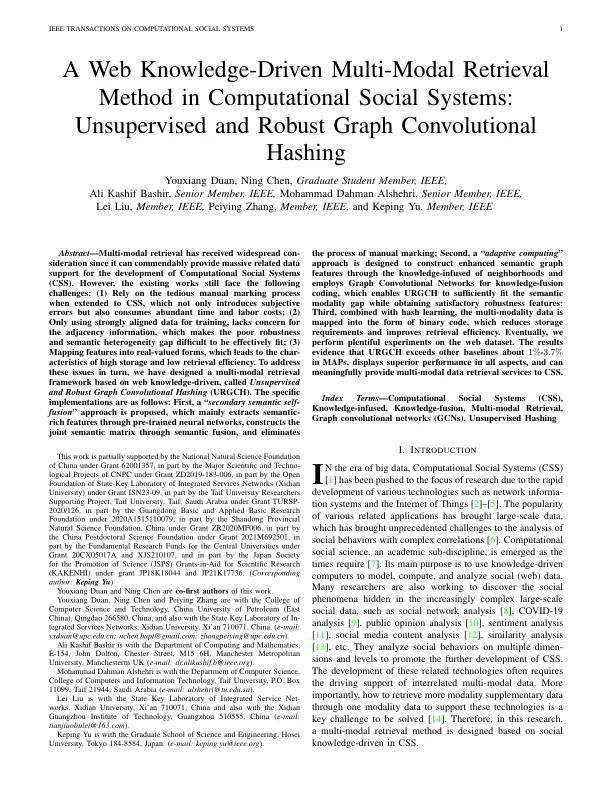

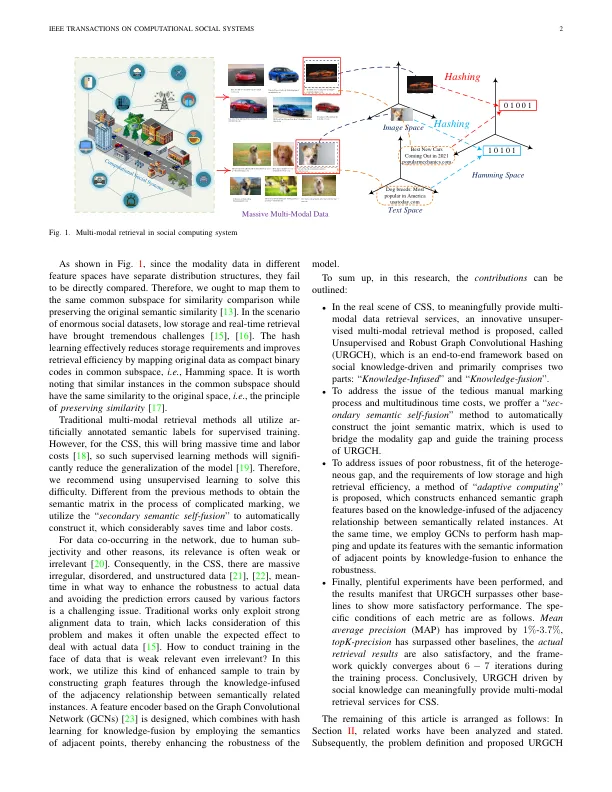

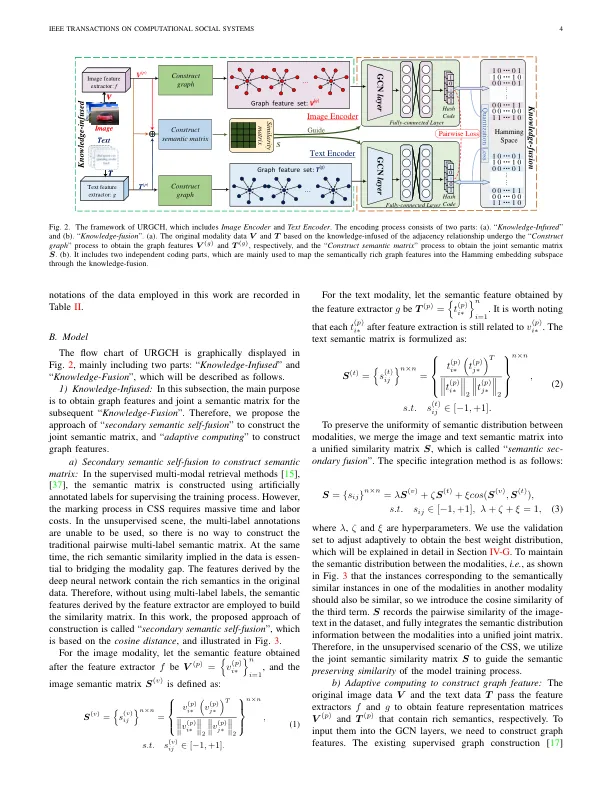

摘要 - Multi-Modal检索已获得广泛的介绍,因为它可以称赞为计算社会系统(CSS)的开发提供大量相关的数据支持。但是,现有作品仍然面临以下挑战:(1)扩展到CSS时依靠乏味的手动标记过程,这不仅引入了主观错误,而且会消耗大量的时间和人工成本; (2)仅使用强烈的数据进行培训,因此缺乏对邻接信息的关注,这使得难以有效拟合的稳健性和语义异质性差距很差; (3)将特征映射到实价形式中,这导致了高储存和低检索效率的特征。为了依次解决这些问题,我们设计了一个基于Web知识驱动的多模式检索框架,称为无监督和健壮的图形卷积哈希(URGCH)。特定的实现如下:首先,提出了一种“二级语义自我融合”方法,该方法主要通过预训练的神经网络提取语义丰富的特征,通过语义融合构建联合语义矩阵,并消除

请引用已发表的版本Duan,Youxiang ... -E -space

主要关键词