机构名称:

¥ 1.0

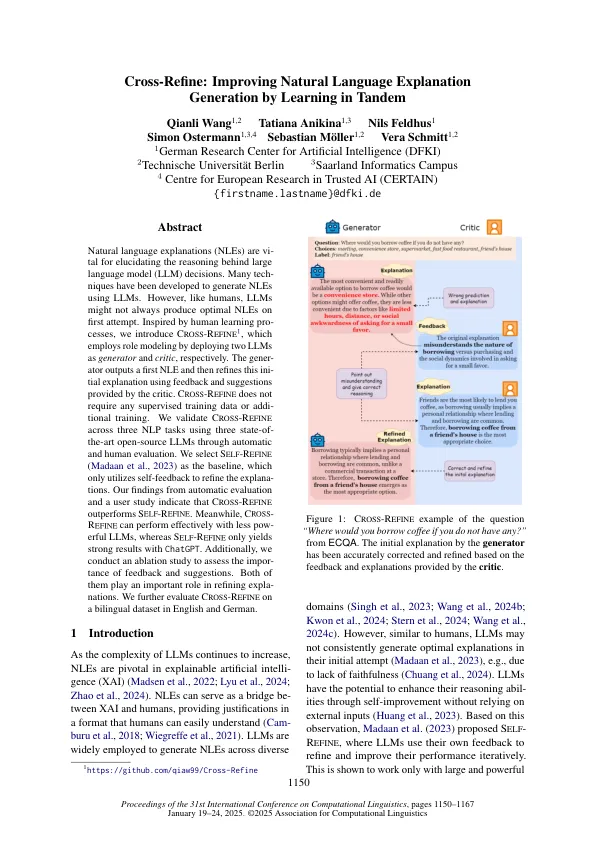

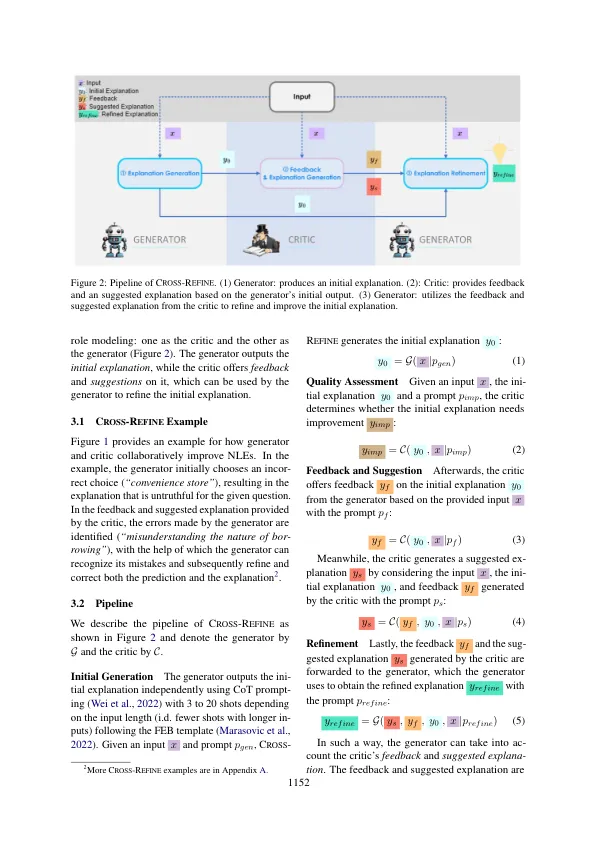

自然语言解释(NLE)是阐明大语模型(LLM)决策背后推理的案例。已经开发了许多技术来使用LLM生成NLS。但是,像人类一样,LLM可能并不总是在第一次尝试时产生最佳的NLE。受到人类学习过程的启发,我们引入了C Ross -R Efine 1,该1分别通过部署两个LLM作为生成器和评论家来采用角色建模。代理人输出了第一个NLE,然后使用评论家提供的反馈和建议来完善这种易于解释。c ross -r efine不需要任何有监督的培训数据或附加培训。我们通过自动和人类评估使用三个最新的开源LLM验证了三个NLP任务中的C ROSS -R efine。我们选择S ELF -R Efine(Madaan等人,2023)作为基线,它仅利用自我反馈来完善解释。我们从自动评估中的发现和用户研究表明,C ROSS -R efine的表现优于S ELF -R efine。同时,C ross -r efine可以使用较少的功能LLM有效地执行,而S Elf -R efine仅通过ChatGpt产生强劲的结果。此外,我们进行了一项消融研究,以评估反馈和建议的重要性。他们俩在完善解释中起着重要作用。我们在英语和德语的双语数据集上进一步评估了c ross -r efine。

交叉雷丁:通过学习中的学习来改善自然语言的解释

主要关键词