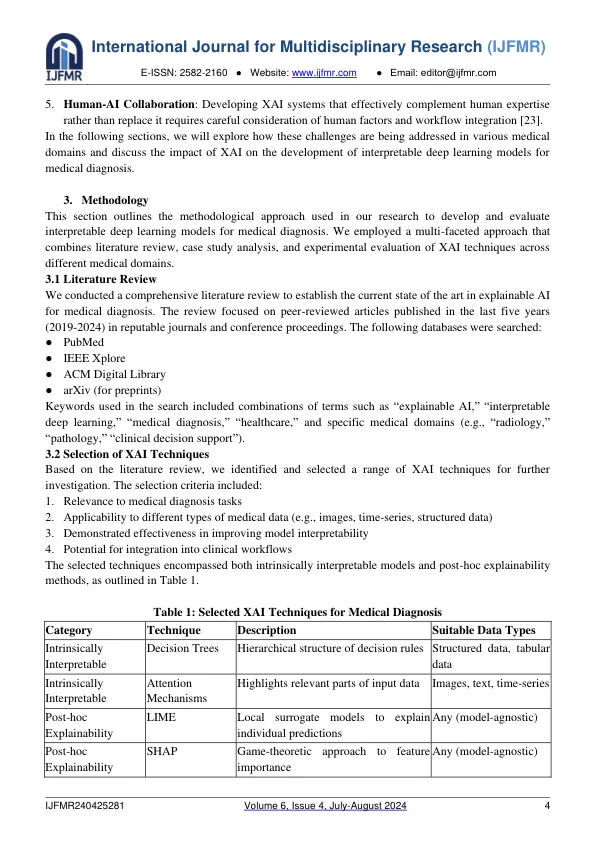

抽象人工智能(AI)和深度学习(DL)在增强各种专业的医学诊断方面具有巨大的潜力。然而,这些模型的固有复杂性和不透明性在临床采用方面构成了重大挑战,特别是由于医疗保健决策的批判性质。本研究论文探讨了可解释的深度学习模型用于医学诊断的发展,重点是将可解释的AI(XAI)技术整合起来,以提高透明度,问责制和对AI辅助医疗决策的信任。我们研究了各种XAI方法,它们在不同的医疗领域的应用以及它们对诊断准确性和临床解释性的影响。通过对案例研究的全面分析,我们证明了可解释的模型如何不仅可以保持较高的诊断性能,还可以为其决策过程提供宝贵的见解,从而有可能彻底改变了AI和人类医疗保健专业知识之间的协同作用。关键字:可解释的AI;深度学习;医学诊断;解释性;卫生保健;人工智能1。简介医疗保健中人工智能(AI)和深度学习(DL)的整合在增强医学诊断,治疗计划和患者护理方面表现出了巨大的希望。这些高级计算模型已经证明了在图像识别,自然语言处理和复杂模式识别等任务中通常匹配或超过人类表现的功能[1]。在医学诊断领域中,AI系统在检测医学成像,预测患者预后以及识别可能会忽略甚至可能经历过医疗保健专业人员的临床数据中的细微模式方面取得了显着的准确性[2]。但是,在临床环境中广泛采用AI是一个重大障碍:许多深度学习模型的“黑匣子”性质。这些模型的复杂性和不透明度使医疗保健提供者了解和信任AI生成的诊断和建议背后的推理[3]。缺乏解释性引起了人们对责任制,患者安全以及依靠AI进行关键医疗决策的道德意义的担忧。可解释的AI(XAI)已成为一个关键领域,旨在通过开发方法和技术来使AI系统更透明和可解释[4]来应对这些挑战。在医学诊断的背景下,XAI试图解开深度学习模型的决策过程,提供有关这些系统如何得出结论并实现医疗保健

可解释的AI:开发可解释的深度学习...

主要关键词