机构名称:

¥ 1.0

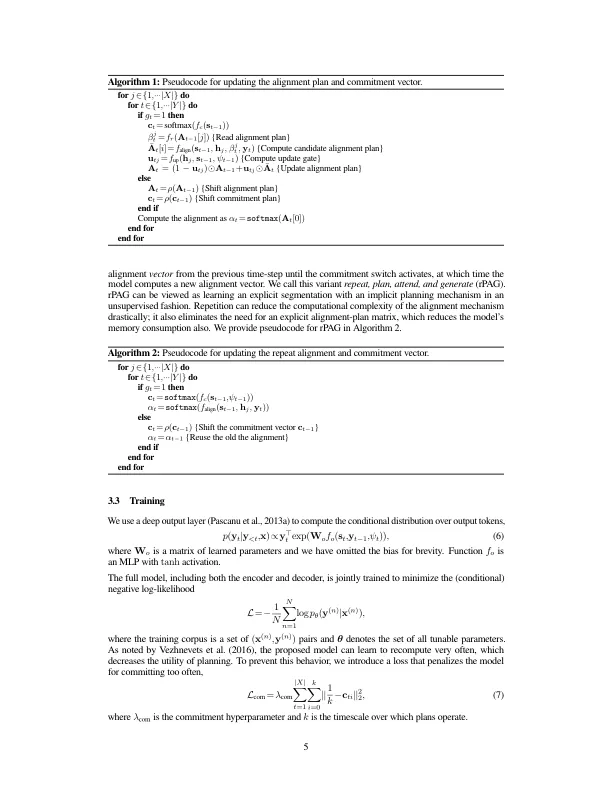

我们研究了使用注意力机制将规划机制集成到序列到序列模型中。我们开发了一个模型,该模型可以在计算输入和输出序列之间的对齐时提前规划未来,构建一个拟议未来对齐矩阵和一个承诺向量,该承诺向量决定是否遵循或重新计算计划。该机制的灵感来自最近提出的强化学习战略性专注读者和作家 (STRAW) 模型。我们提出的模型是端到端可训练的,主要使用可微分操作。我们表明,它在 WMT'15 的字符级翻译任务、查找图的欧拉电路的算法任务以及从文本生成问题方面的表现优于强大的基线。我们的分析表明,该模型计算出定性的直观对齐,比基线收敛得更快,并且以更少的参数实现了卓越的性能。

计划、参加、生成:规划序列到...