机构名称:

¥ 1.0

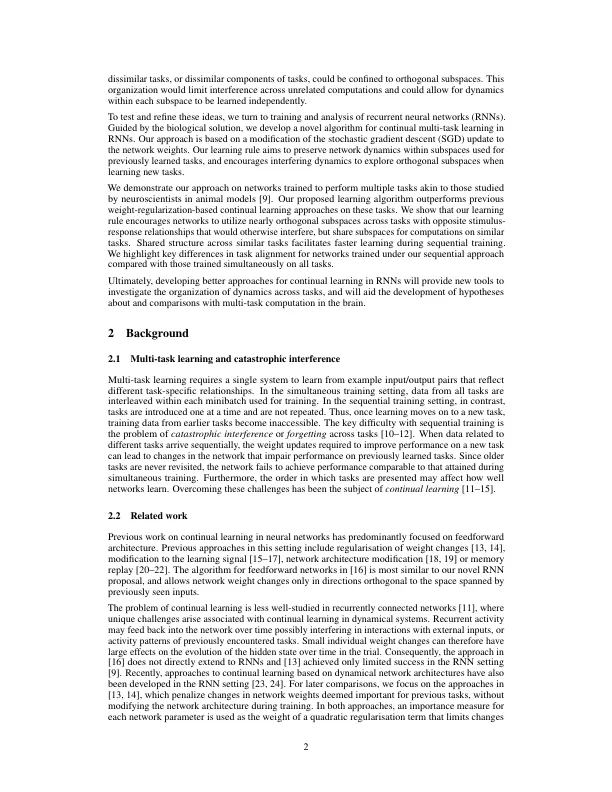

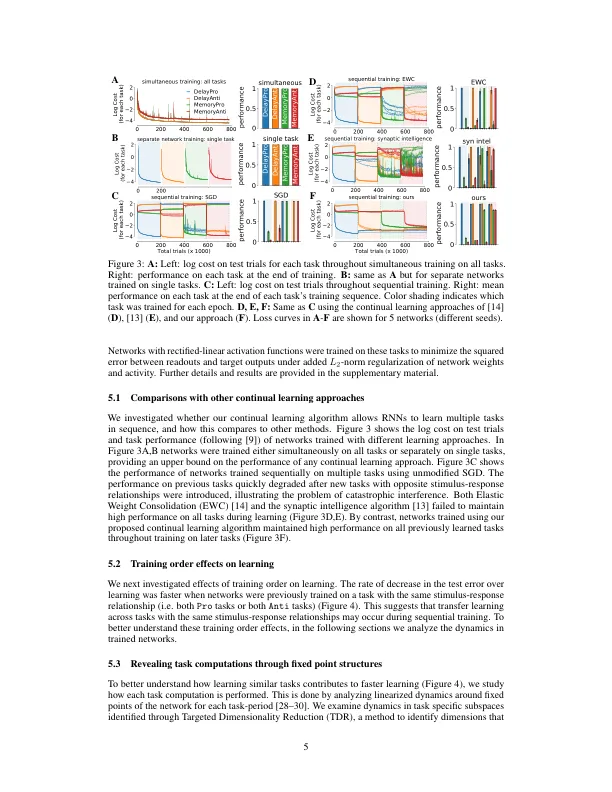

生物系统面临需要持续学习的动态环境。尚不清楚这些系统如何平衡学习和鲁棒性的灵活性之间的张力。在没有灾难性干扰的情况下,持续学习也是机器学习中的一个具有挑战性的问题。在这里,我们制定了一种新颖的学习规则,旨在最大程度地减少经常性网络中依次学习的任务之间的干扰。我们的学习规则保留了用于以前学习的任务的活动定义子空间内的网络动态。它鼓励与新任务相关的动态,这些动态可能会探索正交子空间,并允许在可能的情况下重复使用先前建立的动力学主题。采用神经科学中使用的一组任务,我们证明了我们的方法成功消除了灾难性的干扰,并比以前的持续学习算法提供了实质性的改进。使用动力学系统分析,我们表明使用我们的方法训练的网络可以重复使用相似任务的类似动态结构。共享计算的这种可能性允许在顺序训练期间更快地学习。最后,我们确定在依次训练任务与同时训练任务时出现的组织差异。

通过任务组织复发网络动态 -

主要关键词