机构名称:

¥ 16.0

过去几年,深度神经网络 (DNN) 已成为人工智能的主导子领域。机器学习 (ML) 框架(如 TensorFlow [10])有助于在高抽象级别上设计更强大的神经网络,从而实现新的架构和网络拓扑。FPGA 甚至 ASIC 被证明是加速 DNN 推理的有前途的后端设备,可提供良好的吞吐量和延迟,同时通过多种优化技术解决硬件资源有限的挑战。然而,手工设计这些设计是一项非常耗时的任务,因为 DNN 模型及其工作负载会不断变化,即使对于即将到来的高级综合 (HLS) 领域也是如此。为了弥补生产力方面的差距,已经引入了许多框架,从高级网络描述开始,自动为 FPGA 板 [3-5] 和 ASIC [3] 生成优化的硬件实现。已发布的结果表明,这些框架在性能、延迟和能效方面能够超越最先进的加速器,甚至超越基于 GPU 和 TPU 的解决方案 [3]。本文首先简要概述了最近提出的一小部分框架解决方案,并深入了解了它们的方法。这些框架中的每一个都根据其方法和优化技术定义了一个单独的设计空间。它们大多数自动化设计空间探索 (DSE) 的支柱是专门的预测工具或分析模型,用于估计参数选择将如何影响早期设计阶段的整体性能、能耗或后期硬件系统的面积。提出的结果表明,与实际硬件实现相比,这些预测可以实现可靠的准确性 [3,5],从而有效地选择最佳设计候选方案。在设计周期的早期获取这些信息至关重要

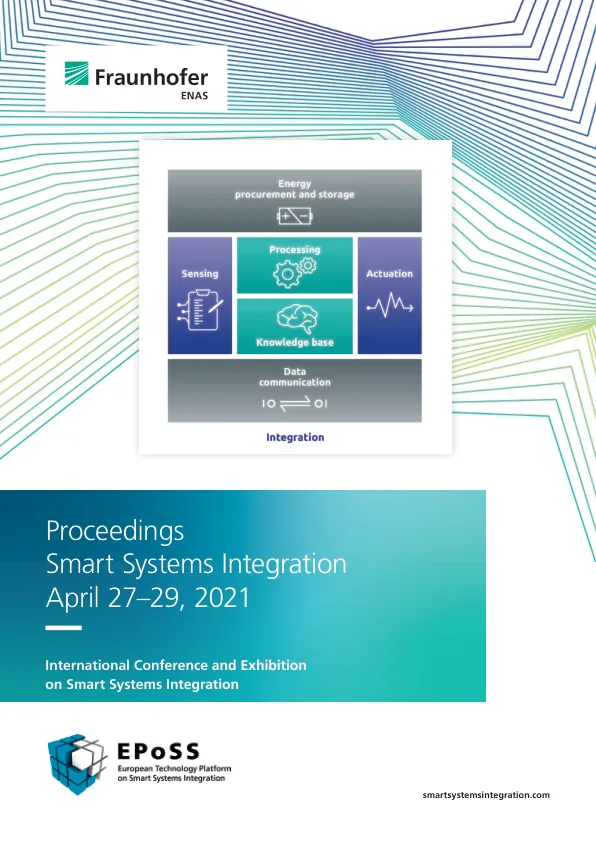

会议论文集 智能系统集成 2021 年 4 月 27 日至 29 日

主要关键词