机构名称:

¥ 1.0

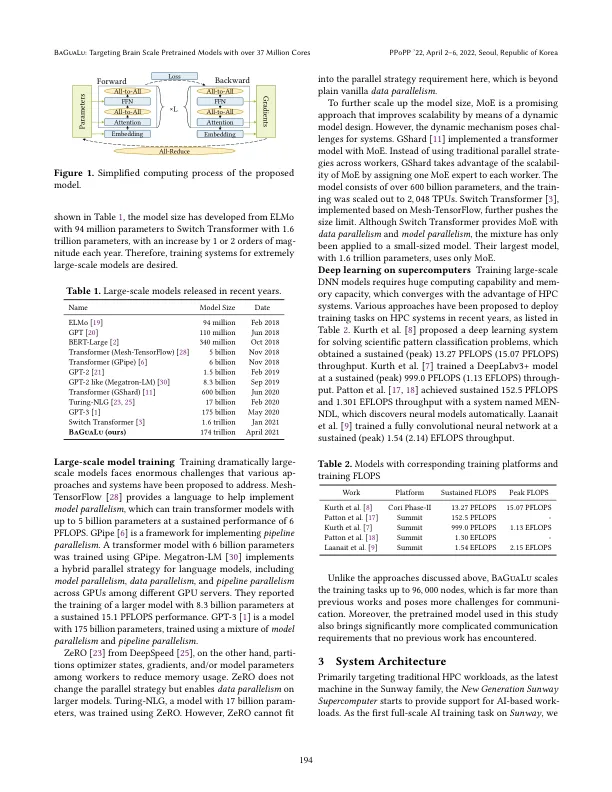

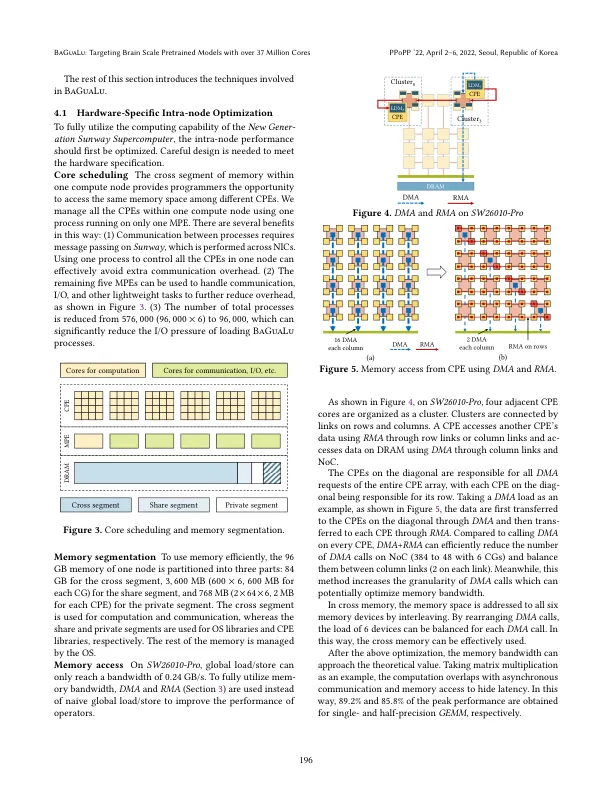

摘要 大规模预训练人工智能模型在一系列重要应用中展现出了极高的准确率。为了实现更高的准确率,预训练人工智能模型的规模每年都在大幅增长,而训练此类模型需要海量的计算和内存能力,这加速了人工智能与高性能计算的融合。然而,在高性能计算系统上部署人工智能应用仍存在不足,需要基于特定硬件特性进行应用和系统协同设计。为此,本文提出了八卦炉1号,这是第一个在百亿亿次超级计算机——新一代神威超级计算机上训练脑规模模型的工作。通过结合针对硬件的节点内优化和混合并行策略,八卦炉在前所未有的大型模型上实现了良好的性能和可扩展性。评估显示,八卦炉可以使用混合精度训练14.5万亿参数模型,性能超过1 EFLOPS,并且有能力训练174万亿参数模型,其数量堪比人脑的突触数量。

八卦炉:针对大脑规模 - ACM 数字图书馆

主要关键词