机构名称:

¥ 1.0

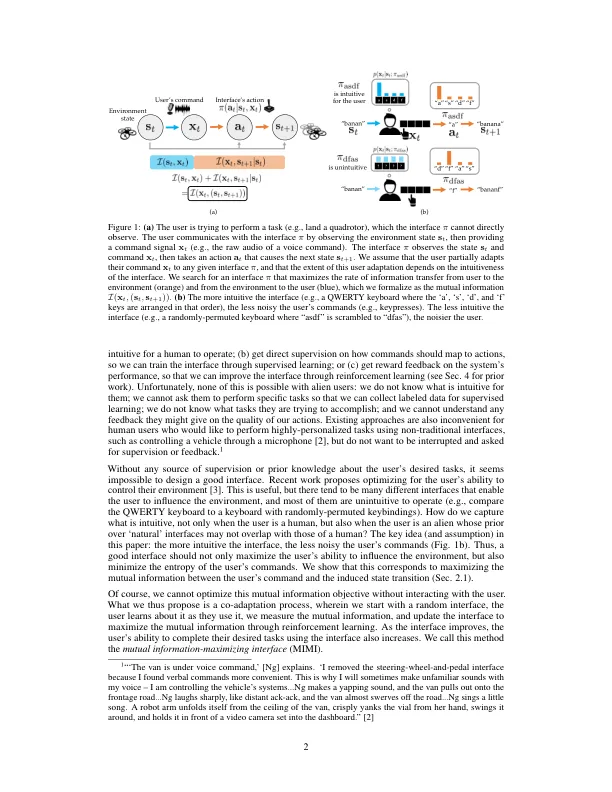

在没有事先映射、无法要求用户以动作标签或奖励反馈的形式进行监督、也不事先了解用户试图完成的任务的情况下,我们如何训练辅助人机界面(例如基于肌电图的肢体假肢)将用户的原始命令信号转化为机器人或计算机的动作?本文的关键思想是,无论任务是什么,当界面更直观时,用户的命令噪音更小。我们将这个想法形式化为优化界面的完全无监督目标:用户命令信号与环境中诱导状态转换之间的相互信息。为了评估这个相互信息分数是否可以区分有效和无效界面,我们对 540K 个用户操作各种键盘和眼神注视界面(用于打字、控制模拟机器人和玩视频游戏)的示例进行了大规模观察性研究。结果表明,我们的相互信息分数可以预测各种领域的实际任务完成情况指标,平均 Spearman 等级相关系数为 ρ = 0.43。除了对现有界面进行离线评估之外,我们还使用无监督目标从头开始学习界面:我们随机初始化界面,让用户尝试使用界面执行他们想要的任务,测量相互信息分数,然后更新界面以通过强化学习最大化相互信息。我们通过一项小规模用户研究来评估我们的方法,该研究有 12 名参与者,他们使用受扰鼠标执行 2D 光标控制任务,并且让一名专家用户使用网络摄像头捕捉到的手势玩月球着陆器游戏。结果表明,我们可以从头开始学习界面,无需任何用户监督或任务的先验知识,只需不到 30 分钟的人机协同训练。

初次接触:通过相互信息最大化实现无监督的人机协同适应

主要关键词