机构名称:

¥ 2.0

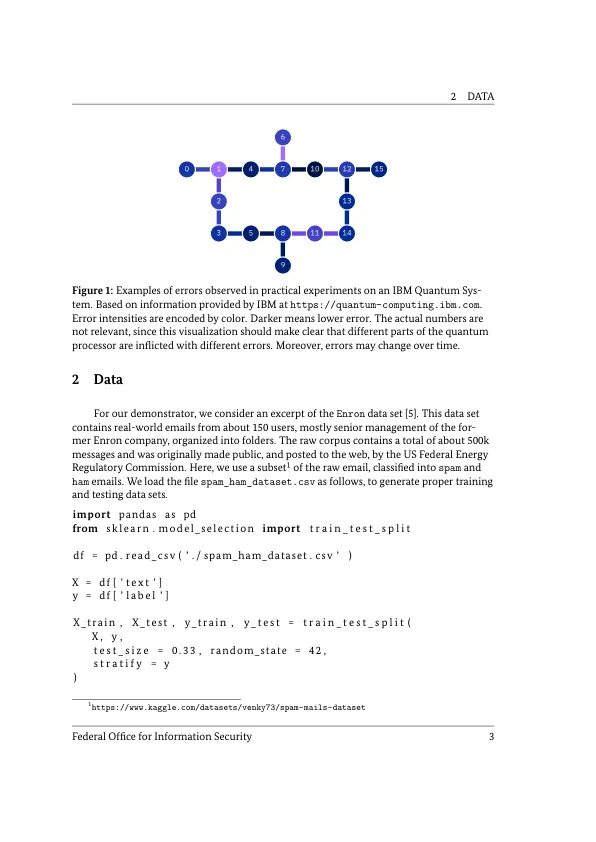

在研究 [1] 中,我们研究了针对 QML 的不同类型攻击。这些攻击可以归类到 QML 管道的不同阶段——从数据收集、预处理到训练、测试再到应用(参见 [1] 第 9 节)。如今,所谓的对抗性攻击在攻击者中很流行,因为被攻击的模型保持完整,这使得攻击很难被发现。更准确地说,数据被操纵是为了故意操纵模型在应用阶段的输出,使其行为符合攻击者的利益(打开后门、进行所需的错误分类等)。在 [1] 的第 11.2 节中,我们还在量子机器学习的背景下考虑了此类攻击,并得出结论,QML 容易受到对抗性攻击,就像传统 ML 的情况一样,并确定了研究问题。QML 对数据噪声的固有鲁棒性提出了一个有趣的研究问题。将恶意操纵的数据重新解释为特定类型的噪声,人们可能想知道 QML 方法是否比传统 ML 更能抵御这种攻击类型。事实上,恶意引入的错误的传播在 QML 中的行为与在传统 ML 中的行为不同(参见 [1],第 11.2 节)。这促使我们从实际角度更深入地研究稳健性。

量子机器学习与安全——演示者

主要关键词