机构名称:

¥ 1.0

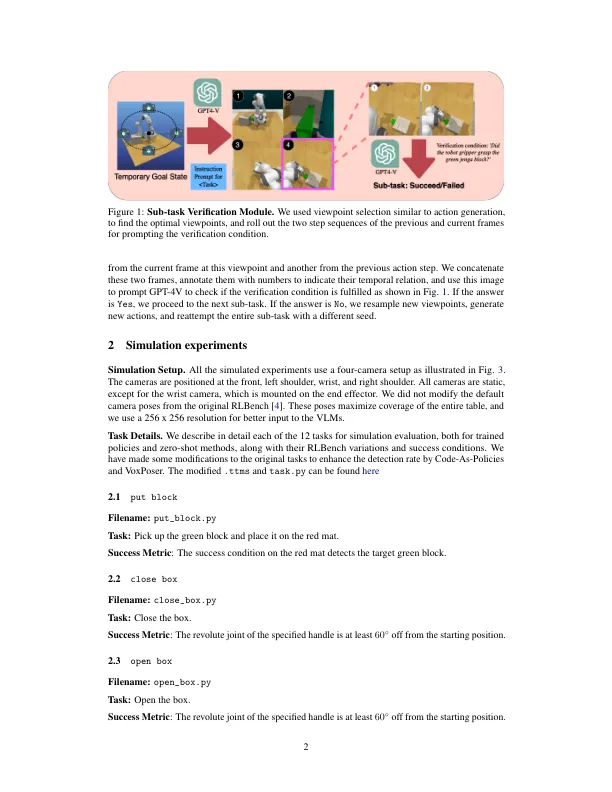

动作生成模块。我们使用以代理为中心或以对象为中心的方法生成每个动作。对于以对象为中心的动作生成,我们利用了NVIDIA的基础掌握预测模型M2T2 [1]进行选择和放置动作。对于6-DOF抓握,我们从单个RGB-D摄像头(在现实世界中)或多个摄像机(在模拟中)输入一个3D点云。该模型在任何可抓取的物体上输出一组掌握提案,提供6-DOF的抓取候选物(3-DOF旋转和3D-DOF翻译)和默认的抓地力关闭状态。对于放置操作,M2T2输出一组6-DOF放置姿势,指示在基于VLM计划执行Drop原始操作之前,最终效应器应在何处。网络确保对象在没有冲突的情况下稳定地定位。我们还设置了mask_threshold和object_threshold的默认值,以控制拟议的GRASP候选人的数量。提出了模板抓取姿势的列表后,我们使用QWEN-VL [2]通过使用机器翻译模型[3]提示当前图像框架来检测目标对象。此检测应用于来自不同相机的所有重新渲染观点或观点。然后,我们将这些帧连接到单个图像中,将每个子图像用右上角的数字注释。接下来,我们将带有几次演示的GPT-4V API调用,并且任务目标提示GPT-4V输出所选数量的视点,这些视点为采样抓取姿势提供了最无用的视图以实现子任务。使用选定的观点,我们通过将最终效果通过运动计划者移动到采样的抓握姿势来执行掌握。

操纵所有内容的补充材料

主要关键词