机构名称:

¥ 1.0

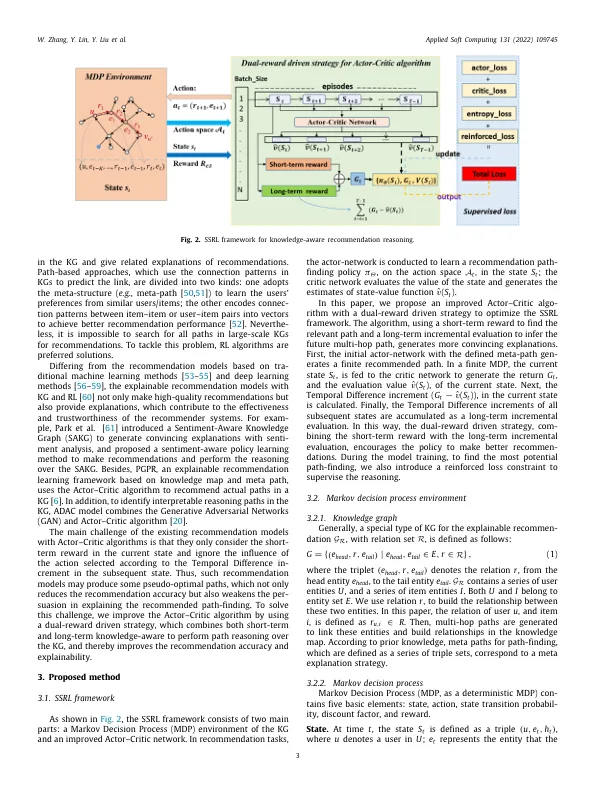

为了提高建议准确性并提供建议的解释,增强学习(RL)已应用于知识图的路径推理。但是,在建议任务中,大多数现有的RL方法仅使用短期或单一的奖励来学习路径调查策略,从而导致本地最佳选择并失去一些潜在的路径。为了解决这些问题,我们提出了一个自我监督的强化学习(SSRL)框架,并结合了双重回报,以实现知识图表的知识建议推理。然后,我们通过使用双回报驱动的策略来改善参与者 - 批评算法,该策略将短期奖励与长期增量评估相结合。改进的算法在整体情况下有助于政策指南路径推理。此外,要找到最潜在的路径,在改进的参与者 - 批评算法中,每个样品的损耗约束用作加强信号以更新梯度。有了针对基准的一些改进,实验结果证明了我们框架的有效性。©2022 Elsevier B.V.保留所有权利。

自我监督的强化学习与双重回报有关知识感知建议

主要关键词