机构名称:

¥ 6.0

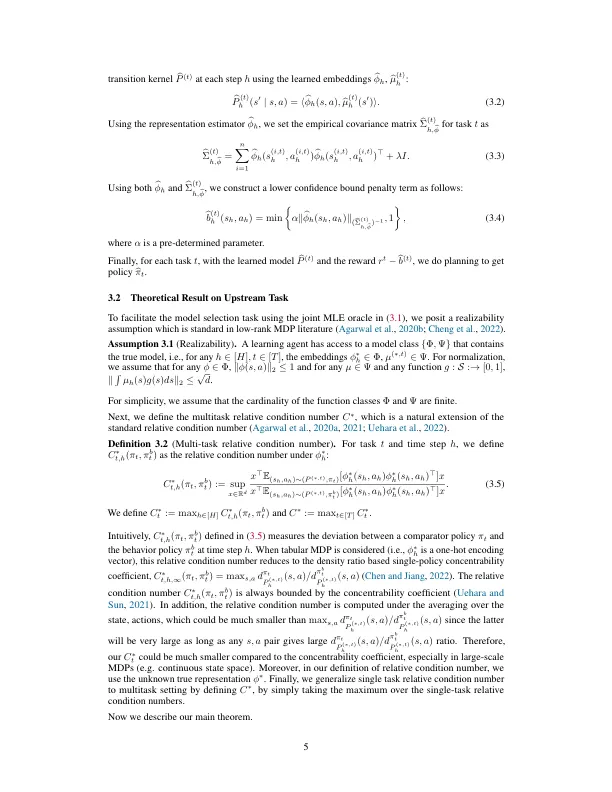

离线增强学习的最新进展(RL)(Levine等人,2020年)使用预采用的数据集为现实世界中的培训政策开辟了可能的可能性(Kalashnikov等人。,2018年; Rafailov等。,2021; Kalashnikov等。,2021),自然语言处理(Jaques等人,2019年),教育(De Lima and Krohling,2021年),电力供应(Zhan等人,2022)和医疗保健(Guez等人,2008年; Shortreed等。,2011年; Wang等。,2018年;基利安等人。,2020)。虽然大多数离线RL研究都集中在单任务问题上,但是在许多实际情况下,多个任务是相关的,并且通过利用所有可用数据共同学习多个任务是有益的(Kalashnikov等人。,2018年; Yu等。,2021,2022; Xie and Finn,2022)。在这种情况下,一种流行的方法是多任务表示学习,该代理的目的是通过在相关任务之间提取共享的低维表示功能来解决问题,然后在此通用表示上使用简单功能(例如线性)来解决每个任务(Caruana,1997; Baxter,2000)。尽管多任务表示学习取得了经验成功,尤其是在增强学习在降低样品复杂性方面的功效方面的实现(Teh等人,2017年; Sodhani等。,2021; Arulkumaran等。,2022),对其的理论理解仍处于早期阶段(Brunskill和Li,2013年; Calandriello等人。,2014年; Arora等。,2020年; Eramo和Al。,2020年;胡和al。,2021; lu和al。,2021; Pacchiano的磨坊,2022年)。虽然

脱机多任务表示增强学习

主要关键词