机构名称:

¥ 3.0

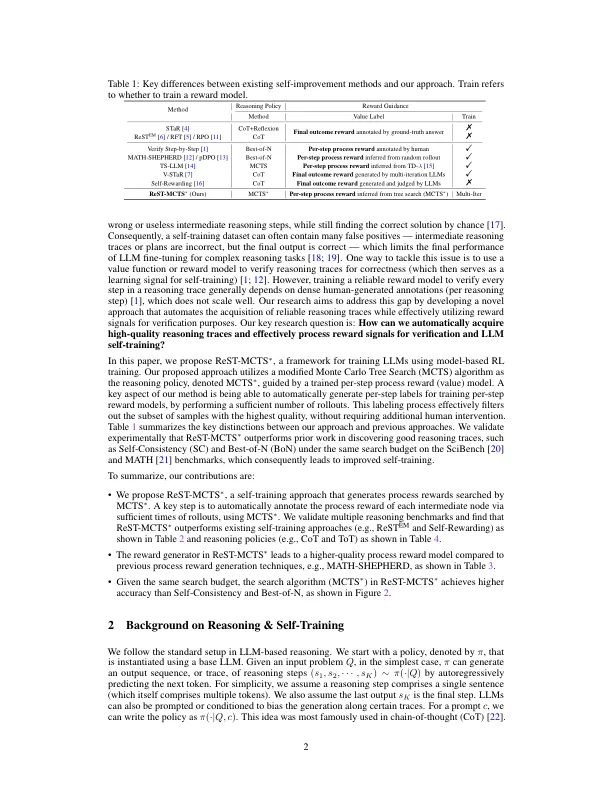

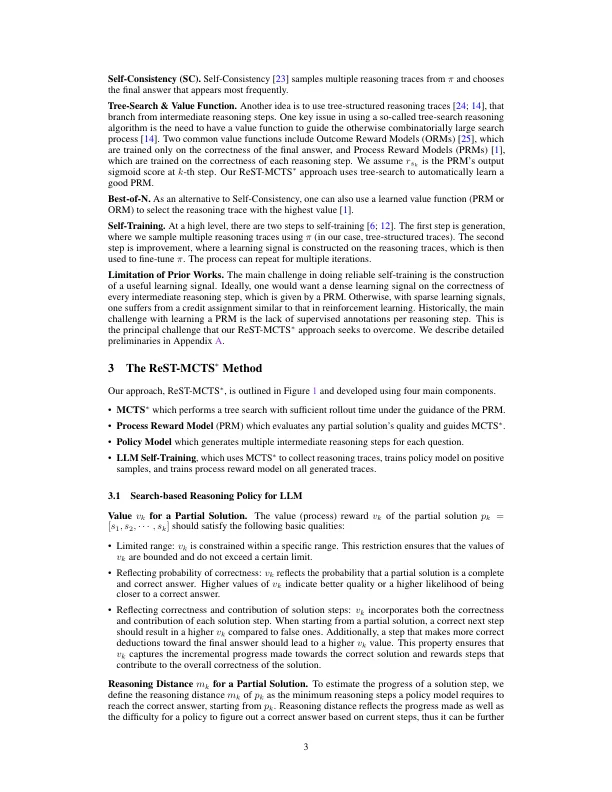

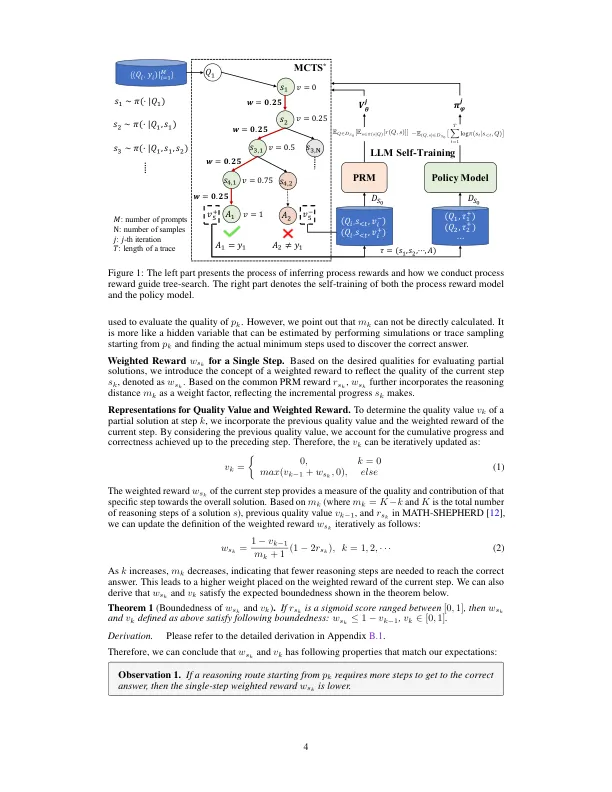

LLM自我训练中的最新方法主要依赖于LLM生成重音,并以正确的输出答案作为培训数据过滤那些。这种方法通常会产生低质量的微调训练集(例如,计划不正确或中间推理)。在本文中,我们开发了一种加强的自我训练方法,称为REST-MCTS ∗,基于将过程奖励指导与树搜索MCTS ∗集成在一起,用于收集高质量的推理痕迹以及每步价值以培训政策和奖励模型。REST-MCT ∗避免了通常用于通过基于树搜索的强化学习来训练过程奖励的每个步骤手动注释:给定的最终正确答案,REST-MCTS ∗能够通过估算此步骤的概率来推断正确的过程奖励,可以帮助您带来正确的答案。这些推断的奖励提供了双重目的:它们是进一步完善过程奖励模型的价值目标,并促进选择高质量的痕迹进行政策模型自我训练。我们首先表明,与先前的LLM推理基线相比,REST-MCTS ∗中的树搜索策略(如在相同的搜索预算中)具有更高的精度。然后,我们证明,通过使用该搜索策略作为培训数据所搜索的痕迹,我们可以不断增强多种迭代的三种语言模型,并超过其他自我训练算法(例如REST EM和自我奖励LM)。我们在https://github.com/thudm/rest-mcts上发布所有代码。

LLM通过过程奖励指导树搜索

主要关键词