机构名称:

¥ 1.0

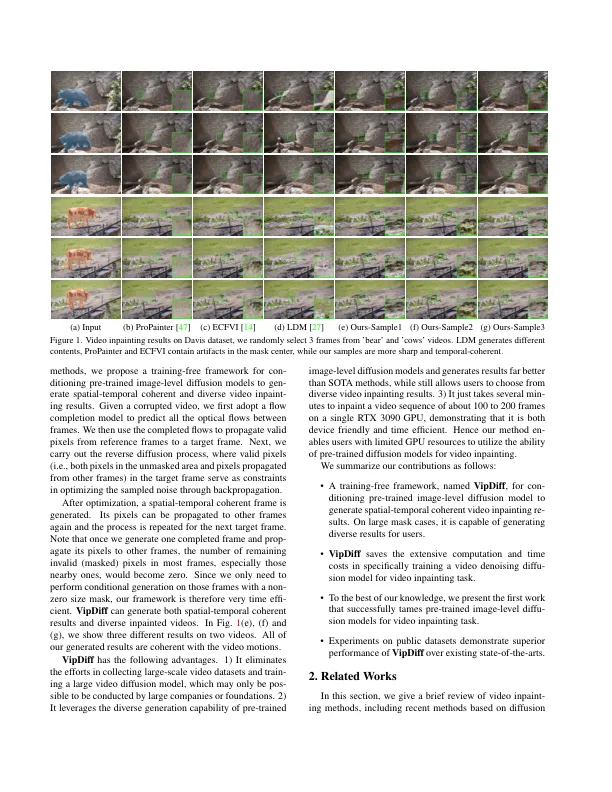

最近的视频介绍方法通过利用光学流以引导像素传播的参考帧或特征空间中的像素传播,从而实现了令人鼓舞的改进。但是,当蒙版面积太大并且找不到像素对应关系时,它们会产生严重的伪影。最近,Denois的扩散模型在产生多样化和高质量的图像时表现出了令人印象深刻的表现,并且已在许多作品中被用于图像插图。但是,这些方法不能直接应用于视频以产生时间连接的覆盖结果。在本文中,我们提出了一个名为Vipdiff的无训练框架,该框架在反向扩散过程中调节扩散模型,以产生时间连接的涂漆结果,而无需任何培训数据或对预训练的模型进行微调。Vipdiff将光流作为指导,从参考帧中提取有效的像素,以作为优化随机采样的高斯噪声的约束,并使用生成的结果来进一步的像素传播和条件生成。Vipdiff还可以通过不同的采样噪声产生各种视频介绍结果。实验表明,我们的Vipdiff在时空连贯性和保真度方面都超过了最先进的方法。

vipdiff:通过无训练的denoising扩散模型迈向连贯而多样的视频介绍

主要关键词