机构名称:

¥ 1.0

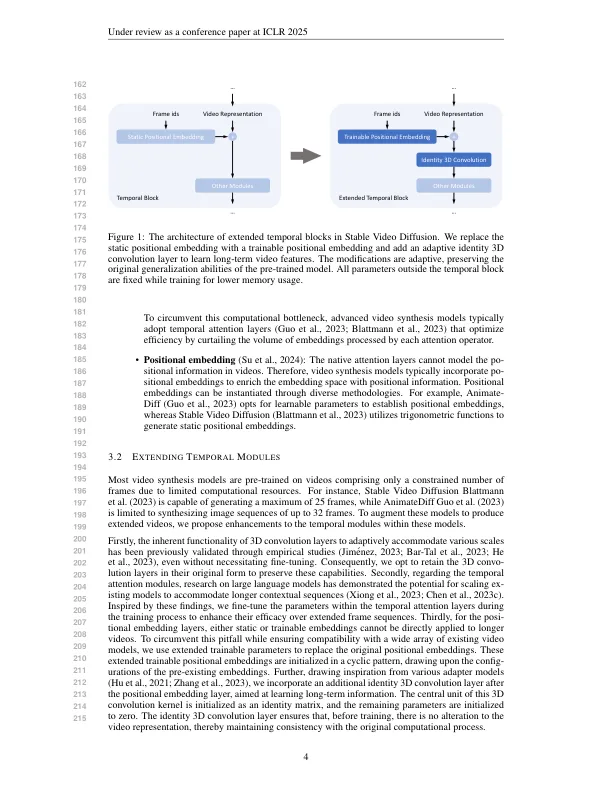

最近,视频合成的进步引起了极大的关注。视频综合模型(例如AnimateIff和稳定的视频扩散)已经证明了扩散模型在创建动态视觉内容时的实际适用性。Sora的出现进一步介绍了视频生成技术的潜力。尽管有进步,但视频长度的扩展仍受到计算资源的限制。大多数现有的视频综合模型仅限于生成简短的视频剪辑。在本文中,我们提出了一种新型的视频合成模型的调节后方法,称为exvideo。这种方法旨在增强当前视频合成模型的能力,使它们能够在延长的时间持续时间内生成内容,同时产生较低的培训支出。尤其是我们分别设计了跨常见的时间模型体系结构的扩展策略,包括3D综合,时间关注和位置嵌入。为了评估我们提出的调整后方法的功效,我们训练了EXSVD,这是一种基于稳定的视频扩散模型的扩展模型。我们的方法增强了该模型最多生成5倍帧数的能力,仅需在包含40k视频的数据集上进行1.5k GPU小时的培训。重要的是,视频长度的实质性增加不会损害模型的先天概括功能,并且该模型在生成各种样式和决议的视频方面具有优势。我们将公开发布源代码和增强模型1。

exvideo:扩展视频扩散模型

主要关键词