机构名称:

¥ 1.0

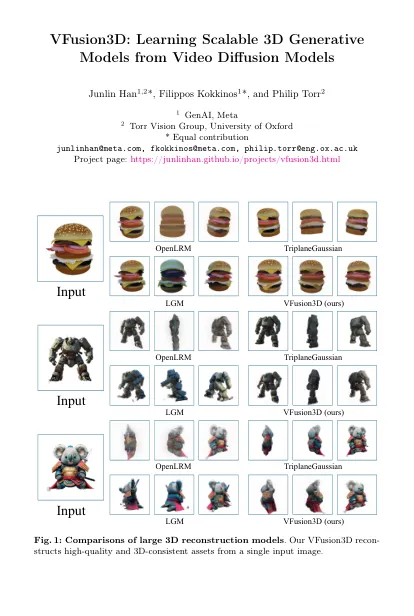

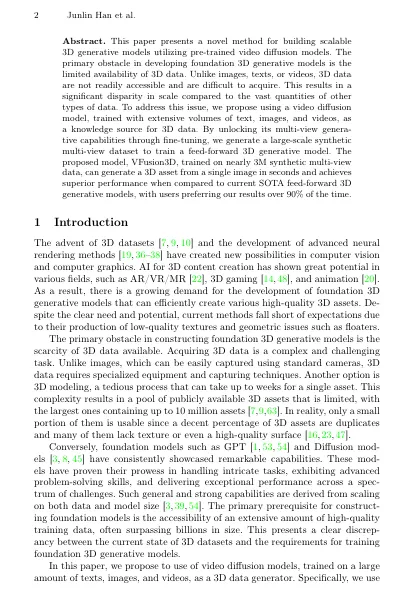

摘要。本文提出了一种利用预训练的视频扩散模型的新方法,用于构建可扩展的3D生成模型。开发基础3D生成模型的主要障碍是3D数据的可用性有限。与图像,文本或视频不同,3D数据不容易访问且难以获取。与大量其他类型的数据相比,这会导致规模差异显着。为了解决这个问题,我们建议使用视频扩散模型,该模型以大量文本,图像和视频培训,作为3D数据的知识源。通过通过微调解锁其多视图的能力,我们生成了一个大规模的合成多视图数据集,以训练一个馈送前进的3D生成模型。对近3M合成多视图数据进行训练的拟议模型Vfusion3D可以以秒的形式从单个图像中产生3D资产,并且与当前的SOTA Feed-Forward 3D生成模型相比,在90%以上的时间中,用户更喜欢我们的结果。

vfusion3d:从视频扩散模型中学习可扩展的3D生成模型