机构名称:

¥ 1.0

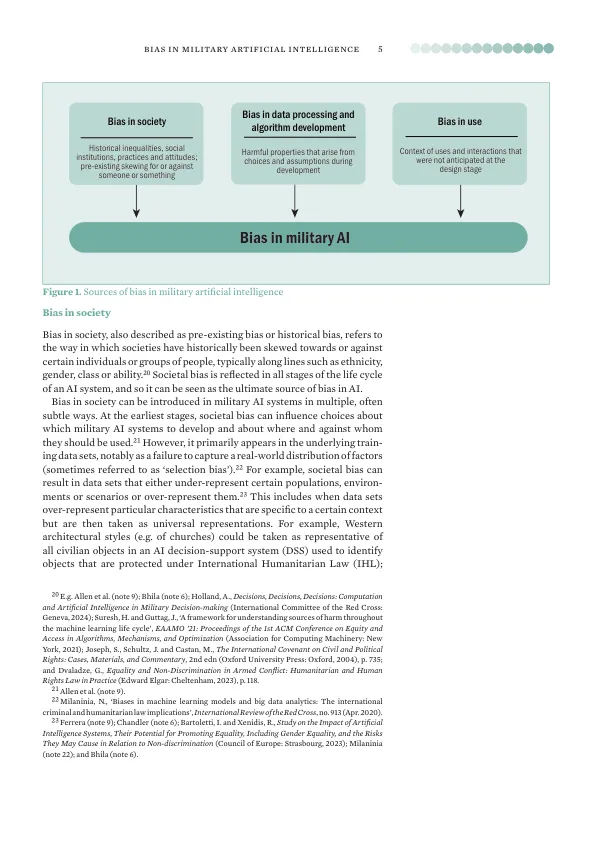

基于种族,性别或阶级等特征,因此与公平问题有关。例如,许多状态(例如阿根廷,法国,巴勒斯坦和塞拉利昂)强调了需要解决AWS对数据集的依赖的风险,“可以永久或扩大了无意的社会偏见,包括性别和种族偏见”。14同样,其他状态(例如奥地利,比利时,加拿大,哥斯达黎加,德国,爱尔兰,墨西哥,巴拿马和乌拉圭)强调了越来越多的文献,即“人工智能中性别和种族偏见的例子”,“基于数据的系统重现存在不平等现象”。15在国家政策声明中也表达了对偏见的类似问题。例如,美国国防部强调对AI的“公平”使用,并承诺“采取故意措施最大程度地减少AI能力的意外偏见”。16同样,英国国防部强调,“算法偏见或偏斜的数据集产生的犯罪结果的风险”特别关注AI支持的军事系统。17这些偏见的说法在很大程度上反映了专家文献的一部分,这些文献将偏见视为不平等的治疗问题。

军事人工智能的偏见

主要关键词