机构名称:

¥ 2.0

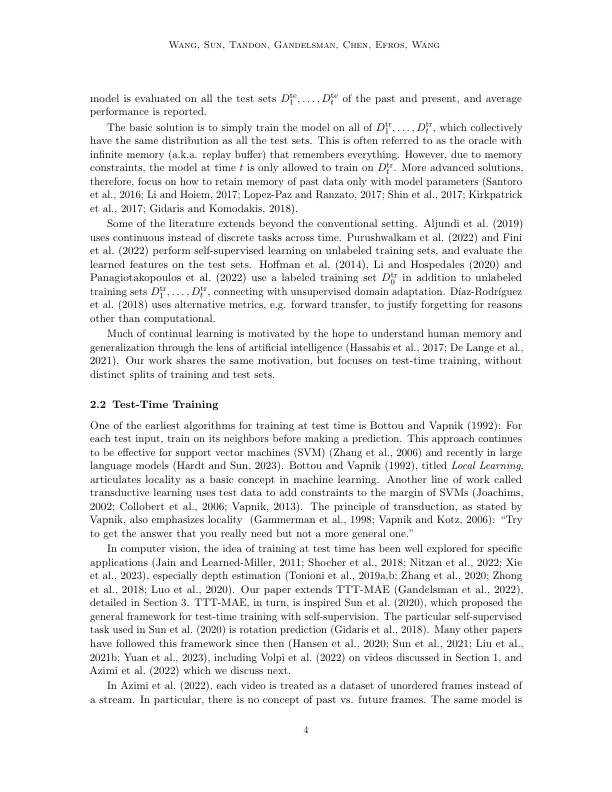

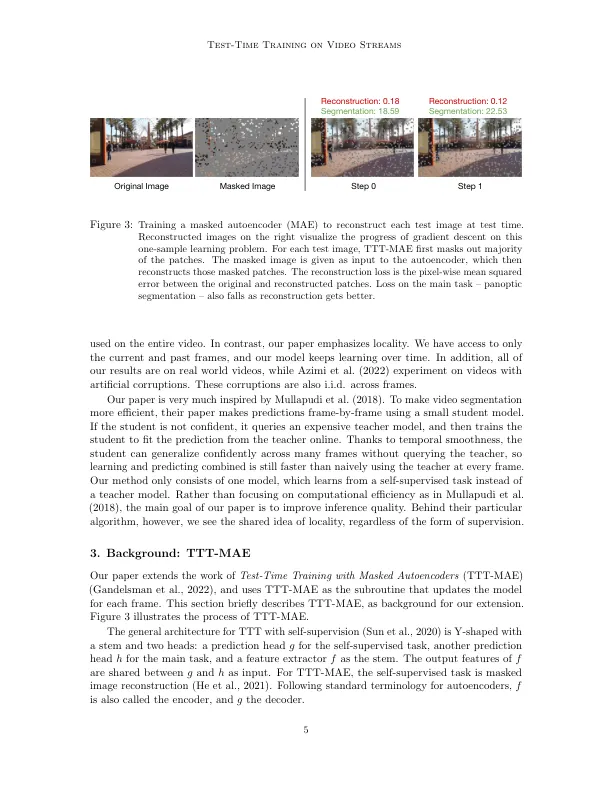

先前的工作已建立了测试时间培训(TTT)作为一般框架,以进一步改善训练有素的模型。在对每个测试实例进行预测之前,模型首先是在同一实例上使用自我监督的任务(例如重建)进行训练。我们将TTT扩展到流设置,其中多个测试实例(我们的情况下的视频帧)以时间顺序到达。我们的扩展名是在线ttt:当前模型是从上一个模型初始化的,然后在当前框架和一个小框架上进行了训练。在线TTT在三个现实世界数据集上显着优于四个任务的固定模型基线。改进超过2.2×和1.5倍,例如全盘分段。令人惊讶的是,在线TTT还胜过其offline变体,该变体严格访问更多信息,对整个测试视频中的所有帧进行培训,而不管时间顺序如何。此发现,使用合成视频挑战了先前的工作中的挑战。我们将当地的概念形式化为在线优于offl ttt的优势,并通过消融和基于偏见 - 差异交易的理论分析其作用。

视频流的测试时间培训