机构名称:

¥ 1.0

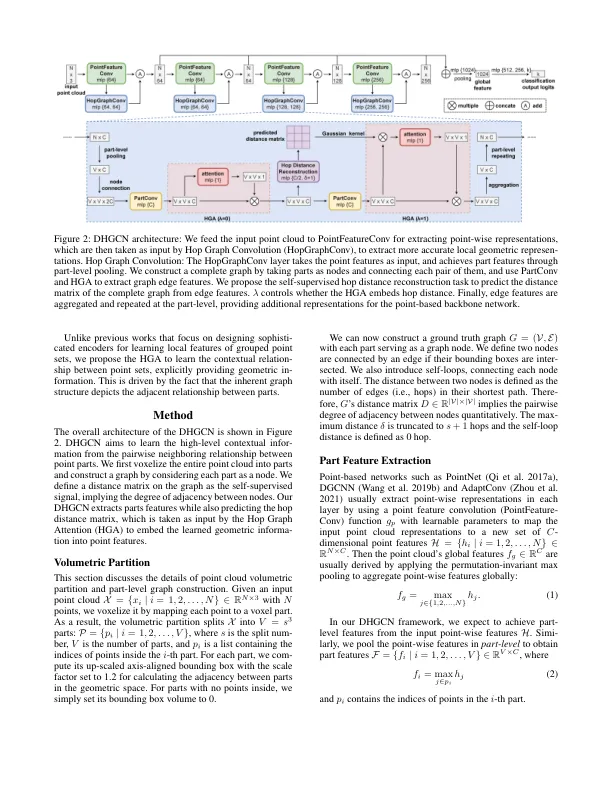

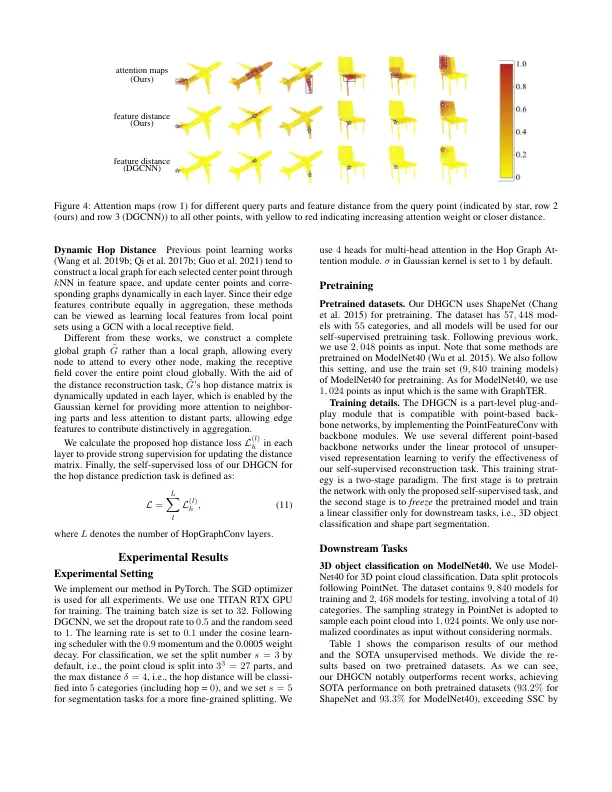

最近的工作试图将图形卷积网络(GCN)扩展到指向分类和分割任务的云。这些作品倾向于在本地进行采样和小组点,并主要集中于通过GCN提取本地特征,同时忽略了点集之间的关系。在本文中,我们提出了Dy-Namic Hop图卷积网络(DHGCN),以详细学习Vox-opiend点部分之间的上下文关系,这些部分被视为图形节点。通过直觉,即上下文信息之间存在的角度在于成对的邻近关系,可以通过图形的跳跃距离来描绘,我们设计了一个新颖的零件级别的霍普距离距离距离距离距离距离重建任务,并设计出一种新颖的损失损失,以相应地训练训练。此外,我们提出了Hop图(HGA),该图将HOP距离作为产生注意力重量的输入,从而可以在聚集中有明显的贡献。最终,提出的DHGCN是一种与基于点的骨干网络兼容的插件模块。对不同骨干和任务的全面实验表明,我们的自我监管方法实现了状态的表现。我们的源代码可在以下网址提供:https://github.com/jinec98/dhgcn。

DHGCN:动态HOP图形卷积网络...

主要关键词