机构名称:

¥ 2.0

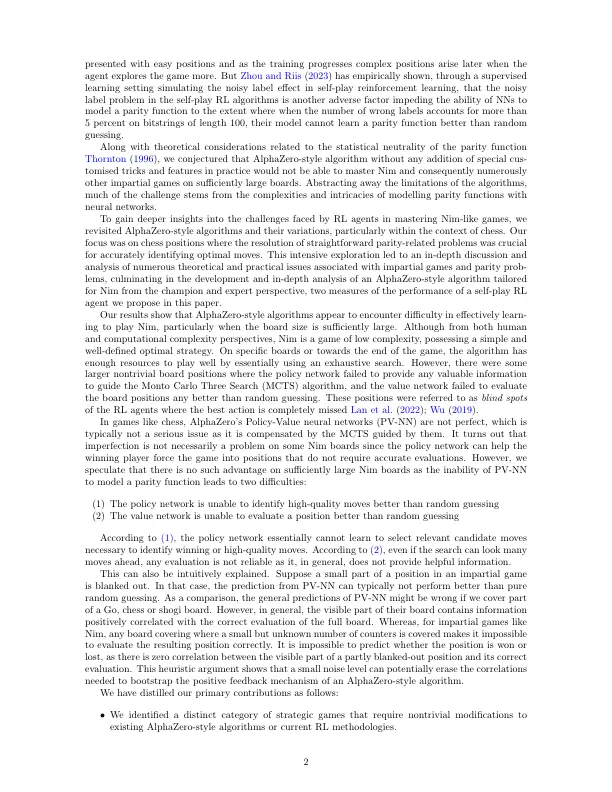

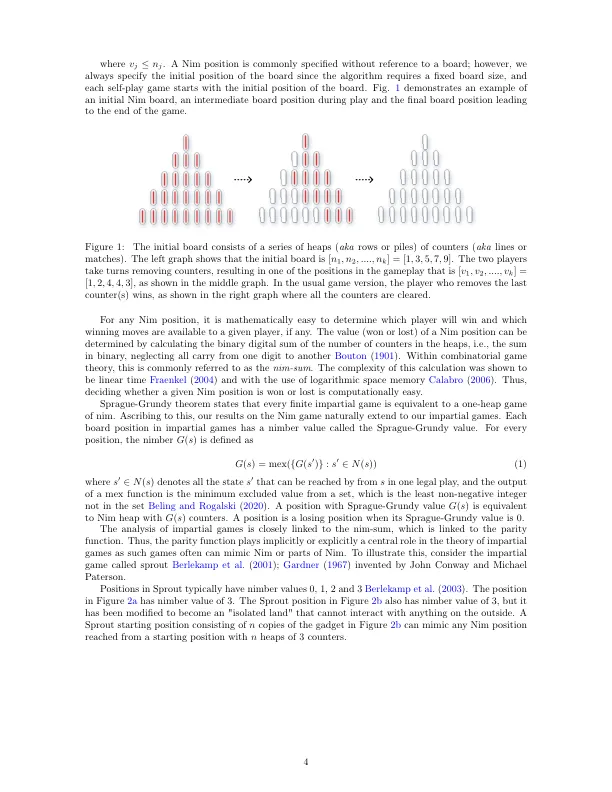

虽然在各种棋盘游戏中,alphazero风格的增强学习(RL)算法出色,但在本文中,我们表明它们在玩家共享作品的公正游戏中面临挑战。我们提出了一个游戏的具体例子 - 即儿童游戏的NIM游戏以及其他公正的游戏,这些游戏似乎是Alphazero风格和类似的自我播放增强学习算法的绊脚石。我们的工作建立在数据分布对神经网络学习奇偶校验功能的能力上的复杂性所带来的挑战,这对嘈杂的标签问题加剧了。我们的发现与最近的研究一致,表明α风格的算法容易受到广泛的攻击和对抗性扰动的影响,这表明学习在所有法律国家中掌握游戏掌握游戏的困难。我们表明,NIM可以在小型董事会上学习,但是当板尺寸增加时,Alphazero-Style算法的学习进度会大大减慢。在直觉上,可以通过以下事实来解释,例如NIM和党派游戏等公正游戏之间的差异,如果董事会在公正游戏中涵盖了董事会的一小部分,通常不可能预测该位置是否会赢得还是丢失,因为通常在部分空白的位置和正确评估的部分之间存在零相关性。这种情况与党派游戏形成了鲜明的对比,其中部分空白的董事会位置通常提供有关完全未透明的位置的价值的丰富或至少非trife信息。

信任软件供应链:启用区块链的SBOM ...公正游戏:加强学习的挑战

主要关键词

![CEO 2纳米纸中光子模式的光谱观察和建模

arxiv:2401.08196v1 [cs.cr] 2024年1月16日

1个基于云的分层模仿学习,可扩展...

arxiv:2309.11256v2 [CS.CR] 2024年1月17日

信任软件供应链:启用区块链的SBOM ...

公正游戏:加强学习的挑战](/simg/9/97a040ad6466b0b474ee909e1146675a41b18c35.webp)