机构名称:

¥ 10.0

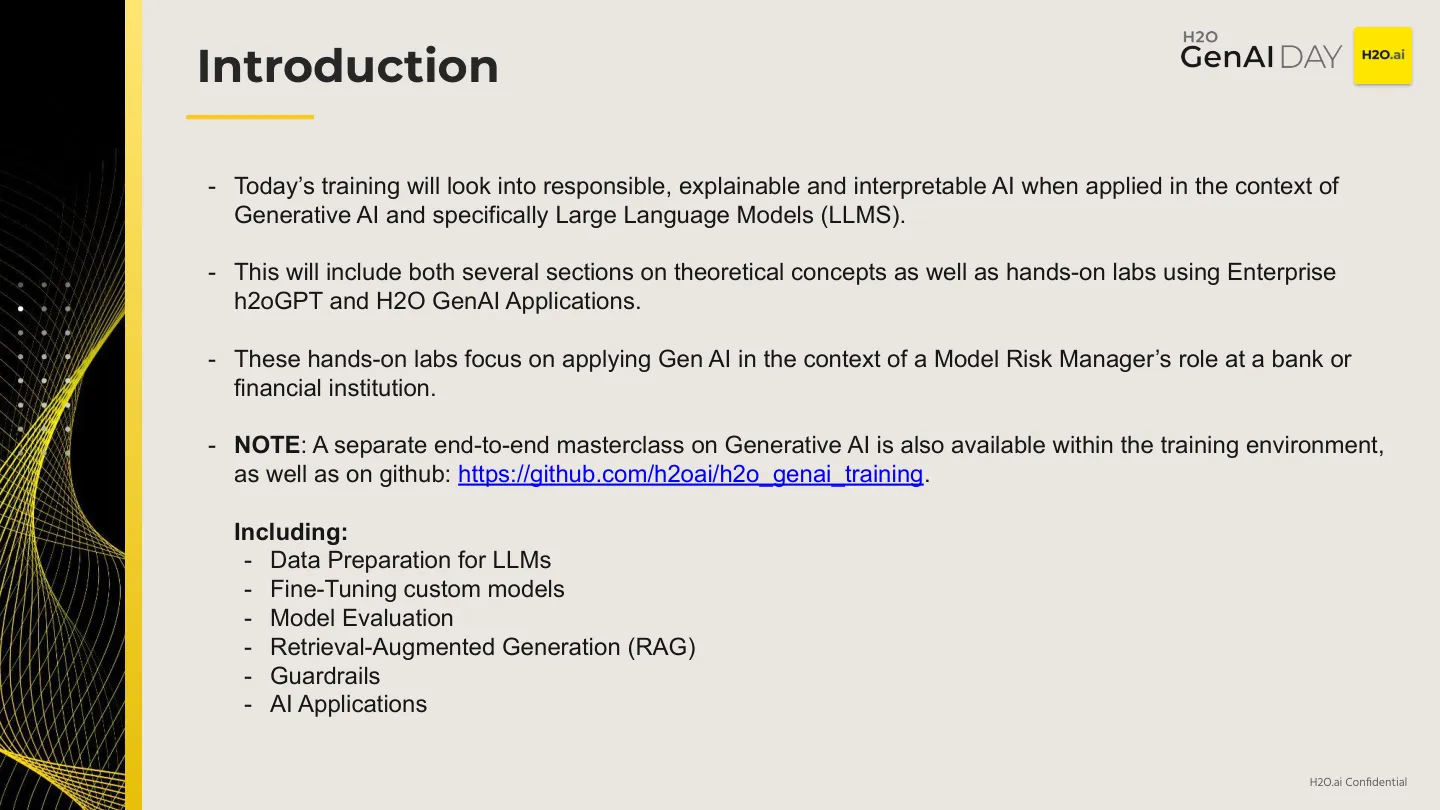

大型语言模型的最新进展也在模型可解释性方面带来了新的挑战。生成模型产生新颖的内容,通常与单个正确的答案不符,因此仅确定结果的准确性比监督机器学习更为复杂。此外,可以根据语气,毒性,准确性,公平性,隐私保存以及其他可能在监督学习中具有模拟的指标来量化文本输出。我将比较监督学习的模型可解释性与可用于理解大语言模型的方法。

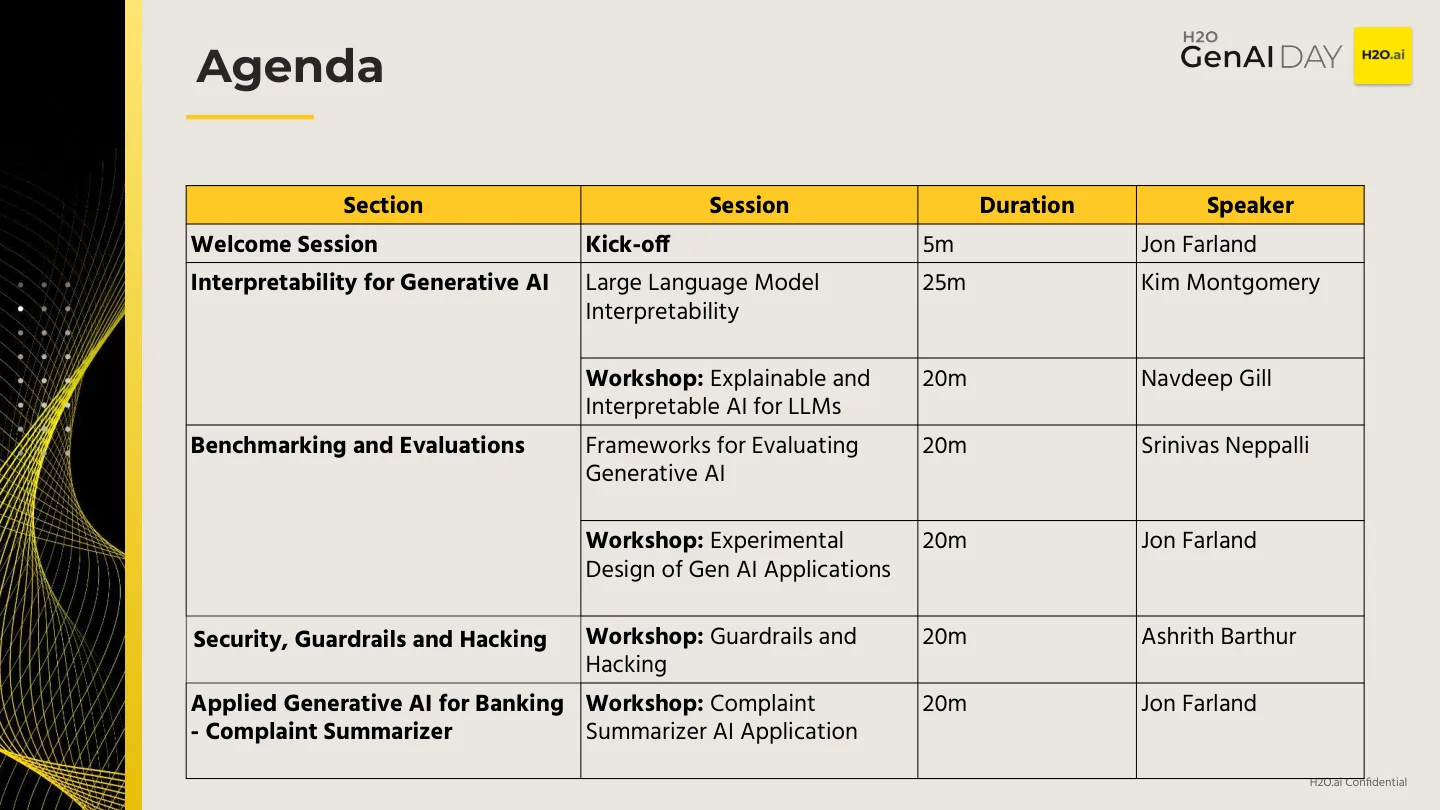

生成AI大师班 - 模型风险管理-H2O.AI