机构名称:

¥ 1.0

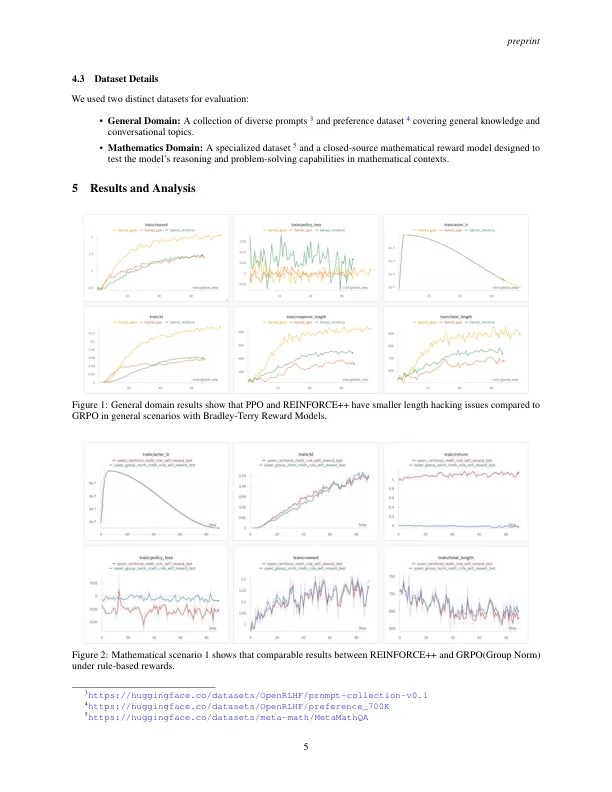

从人类反馈中学习(RLHF)已成为一种至关重要的方法,可以通过诸如近端政策优化(PPO),直接偏好优化(DPO)等方法来使大型语言模型与人类偏好相结合,见证了快速的算法进化,增强了Oneforce One-Out Out-Out Out Ont-Out(Rloo)(RLOO),Remax,Remax,Remax和Group Oppers Policy Optimation(GRPO)(GRP)(GRPO)。我们提出了增强++,这是经典增强算法的增强变体,该变体融合了PPO中的关键优化技术,同时消除了对评论家网络的需求。增强++实现了三个主要目标:(1)简单性(2)增强的训练稳定性,以及(3)减少了计算开销。通过广泛的经验评估,我们证明,与GRPO相比,增强++在保持可比性能的同时,具有比PPO更高的计算效率表现出卓越的稳定性。该实现可在https://github.com/openrlhf/openrlhf上获得。

增强++