机构名称:

¥ 1.0

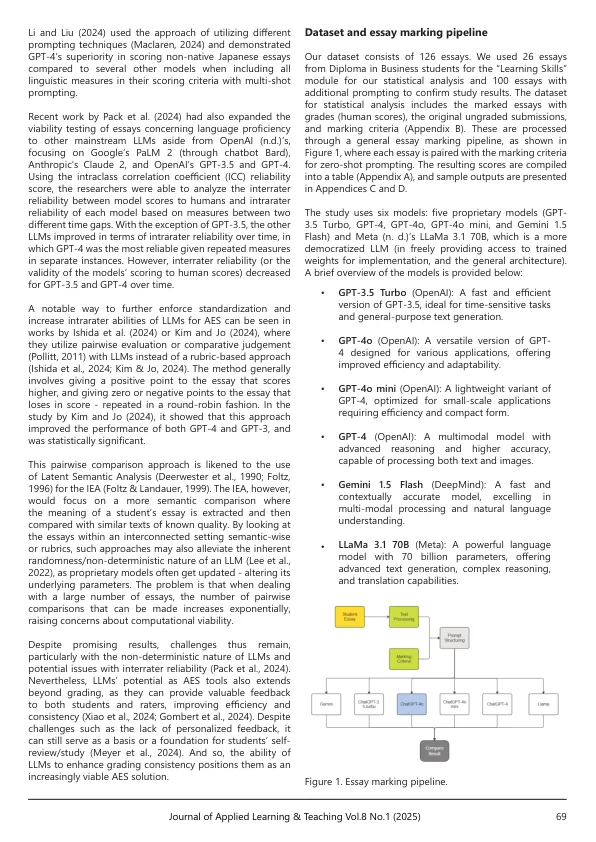

保持自动论文评分中的一致性对于保证公平可靠的评估至关重要。这项研究研究了一致性,并提供了用于自动论文评分(AES)的开源和专有大语模型(LLMS)的比较分析。这项研究利用了学生论文,每个人都评估了五次,以测量几种模型中的内部植物(使用内部系数和可重复性系数)和互间(一致性相关系数)的可靠性:GPT-4,GPT-4,GPT-4,GPT-4O,GPT-4O Mini,GPT-4O Mini,GPT-3.5 Turbo,Gemini 1.5 turbo,gemini 1.5 Flash,Gemini 1.5 Flash和Llama 3.1 70B。文章和标记标准用于及时构造,并发送到每个大型语言模型以获得分数输出。结果表明,GPT-4O产生的分数与人类评估紧密保持一致,表明在重复措施中进行了公平的一致性。具体而言,GPT-4O表现出比GPT-4O MINI的一致性相关系数(CCC)稍高,这表明与人类得分相吻合。但是,可以观察到所有LLM模型在评分理由/评估方面都不一致。我们的研究结果表明,使用大型语言模型的自动论文评分中当前面临的挑战不仅需要从定量的角度来分析,而且还需要从定性上进行分析。此外,我们还利用了更复杂的提示方法,并解决了初始测量中观察到的不一致之处。尽管我们研究中某些模型的可靠性据称是在AES实施过程中的选择,但应彻底考虑LLM的选择。

应用学习与教学杂志

主要关键词