机构名称:

¥ 1.0

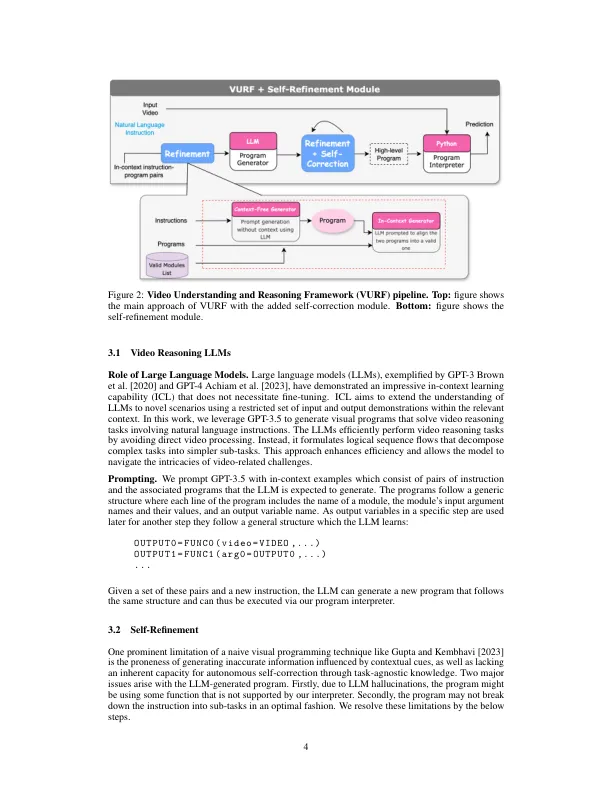

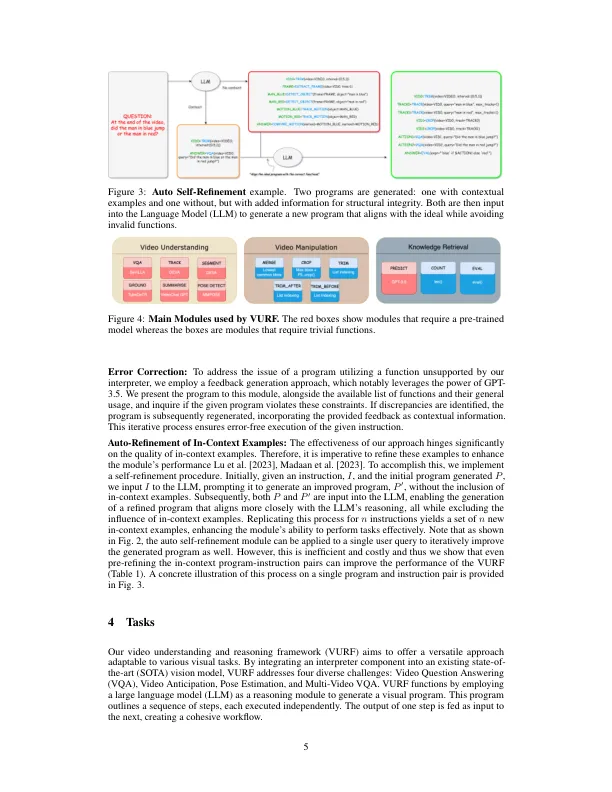

最近的研究表明,大语模型(LLM)作为推理模块的有效性,可以将复杂的任务解构为更加可行的子任务,尤其是应用于图像的视觉推理任务时。相比之下,本文根据LLM的推理能力介绍了视频理解和推理框架(Vurf)。我们的一种新颖的方法是在视频任务的背景下扩展LLM的实用性,并利用它们从上下文框架内的最小输入和输出演示中概括的能力。我们通过使用成对的指令及其相应的高级程序来呈现LLM来利用他们的上下文学习能力,以生成可执行的视觉程序以供视频理解。为了提高计划的准确性和鲁棒性,我们实施了两种重要的策略。首先,我们采用由GPT-3.5提供支持的反馈生成方法,以纠正利用不支持功能的程序中的错误。其次,从最新的LLM输出自我进行的著作中汲取动机,我们通过将初始输出与LLM不受含义示例的结构限制的初始输出与本应生成的输出的结构对齐,从而提出了一种迭代程序,以提高内在示例的质量。我们在几个特定于视频的任务上的结果,包括视觉质量质量检查,视频预期,姿势估计和多效QA,说明了这些增强功能在提高视频任务的视觉编程方法方面的功效。

vurf:视频理解的通用推理和自我填写框架

主要关键词