机构名称:

¥ 2.0

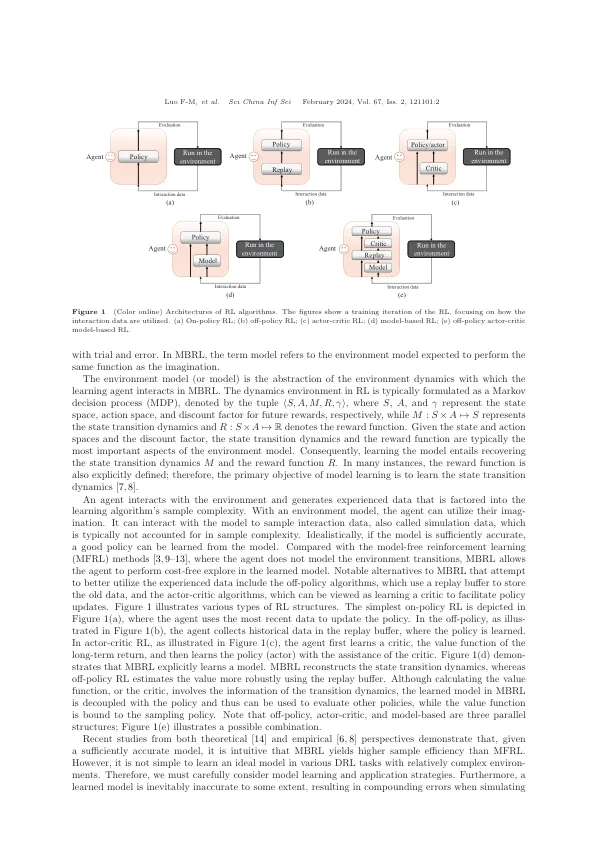

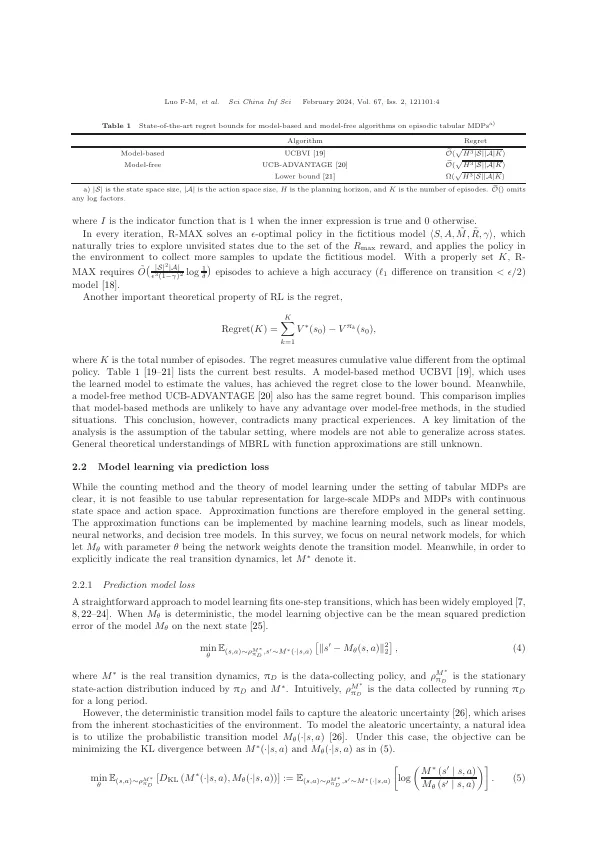

抽象的增强学习(RL)与环境相互作用,以通过反复试验解决顺序决策问题。错误在现实世界中的应用程序总是不受欢迎的,即使RL擅长玩复杂的视频游戏,这些游戏允许进行多次试用和错误尝试。为了提高样本的效率并减少错误,基于模型的加固学习(MBRL)被认为是一个有前途的方向,因为它构建了可以在不产生实际成本的情况下进行反复试验的环境模型。在这项调查中,我们调查了MBRL,特别关注Deep RL的最新进展。在非尾环环境的学习模型与实际环境之间存在概括性误差。因此,至关重要的是要分析环境模型中的政策培训之间的差异,即在实际环境中,指导算法设计,以改善模型学习,模型利用和政策培训。此外,我们讨论了其他形式的RL,例如offline rl,目标条件的RL,多代理RL和Meta-RL的最新发展。此外,我们讨论了MBRL对现实世界任务的适用性和收益。最后,这项调查结束了关于MBRL未来发展前景的讨论。我们认为,MBRL在现实世界中具有巨大的潜力和利益,我们希望这项调查将鼓励对MBRL的更多研究。

一项关于基于模型的强化学习的调查

主要关键词