机构名称:

¥ 1.0

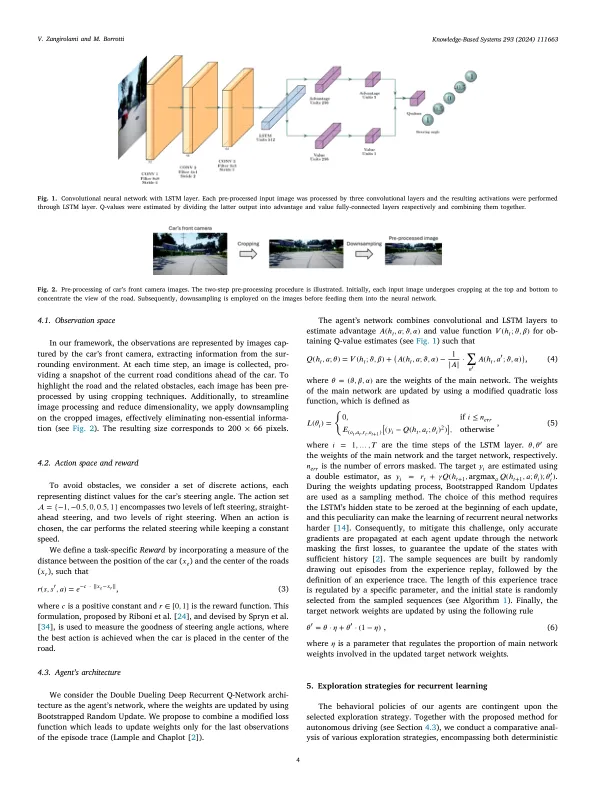

对环境的不完整知识导致代理在不确定性下做出决定。强化学习(RL)的主要困境之一,即自主代理在做出决策时必须平衡两个对比需求的是:利用当前对环境的知识以最大程度地提高累积奖励,并探索允许环境知识的行动,希望提高环境的知识,希望带来更高的奖励价值(探索奖励价值(Exploritation-explotitation-explotitation-explopolitation-opploplotiting-offriatition-offlotiting-trifcount)。同时,另一个相关问题指的是各州的全部观察性,这在所有申请中都可能不假定。例如,当2D图像被视为用于在3D模拟环境中找到最佳动作的RL方法中的输入时。在这项工作中,我们通过部署和测试几种技术来解决这些问题,以平衡探索和剥削的权衡,以在自主驾驶场景中预测转向车轮的部分可观察到的系统。更确切地说,最终的目的是研究使用自适应和确定性探索策略以及深层复发Q-NETWORK的影响。此外,我们改编并评估了修改后的二次损失函数的影响,以改善基础卷积复发性神经网络的学习阶段。我们表明,自适应方法可以更好地近似探索和剥削之间的权衡,而且通常,SoftMax和Max-Boltzmann策略的表现优于绿化技术。

IBD相关脊椎关节炎的抑制剂

主要关键词