机构名称:

¥ 1.0

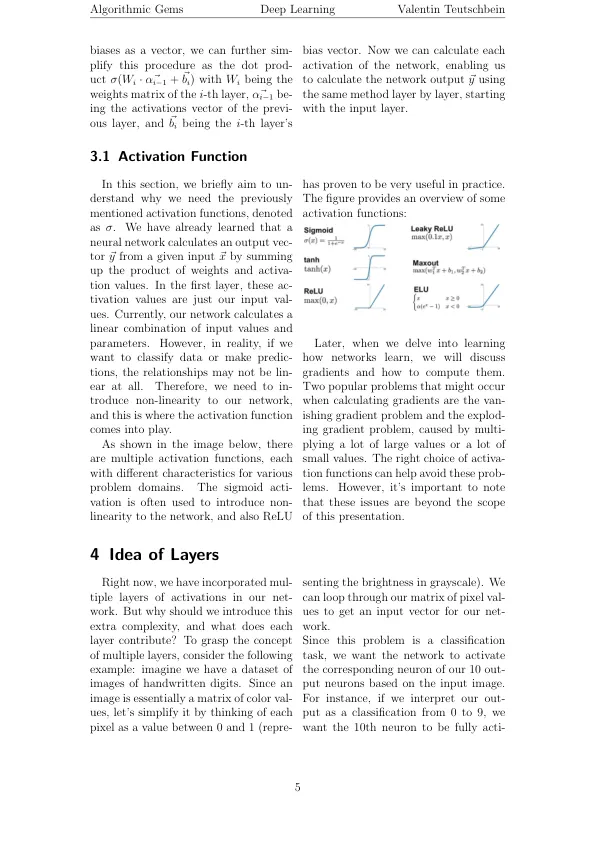

在本节中,我们简要旨在取消明白为什么我们需要前面提到的激活功能,称为σ。我们已经了解到,神经网络通过总结权重和激活值的乘积来计算从给定输入⃗X的输出vecter。在第一层中,这些进化值只是我们的输入阀。当前,我们的网络计算输入值和参数的线性组合。实际上,如果我们要对数据进行分类或做出预测,则关系可能根本不存在。因此,我们需要对网络进行非线性,这是激活函数发挥作用的地方。如下图所示,有多个激活函数,每个功能都有不同的问题域的特征。Sigmoid Activation通常用于将非线性引入网络,也可以relu

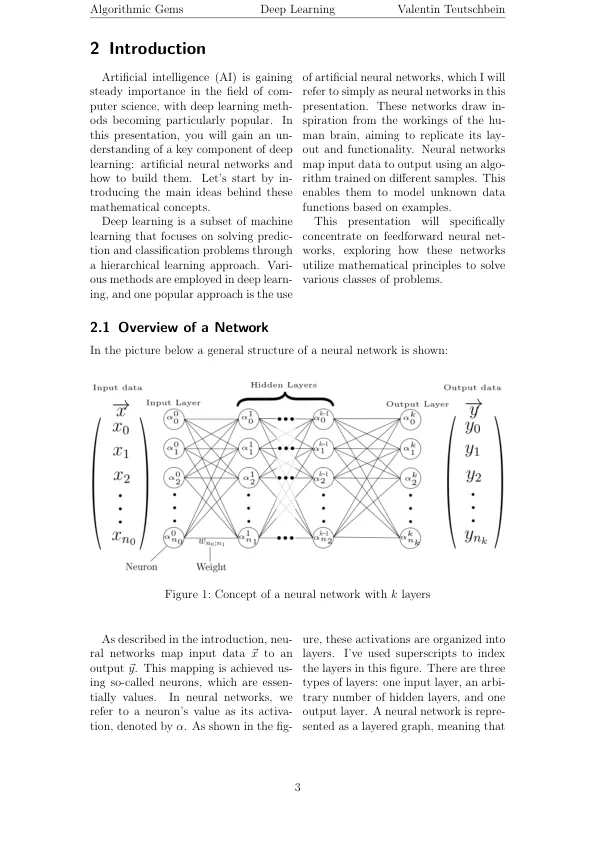

了解神经网络背后的数学

主要关键词